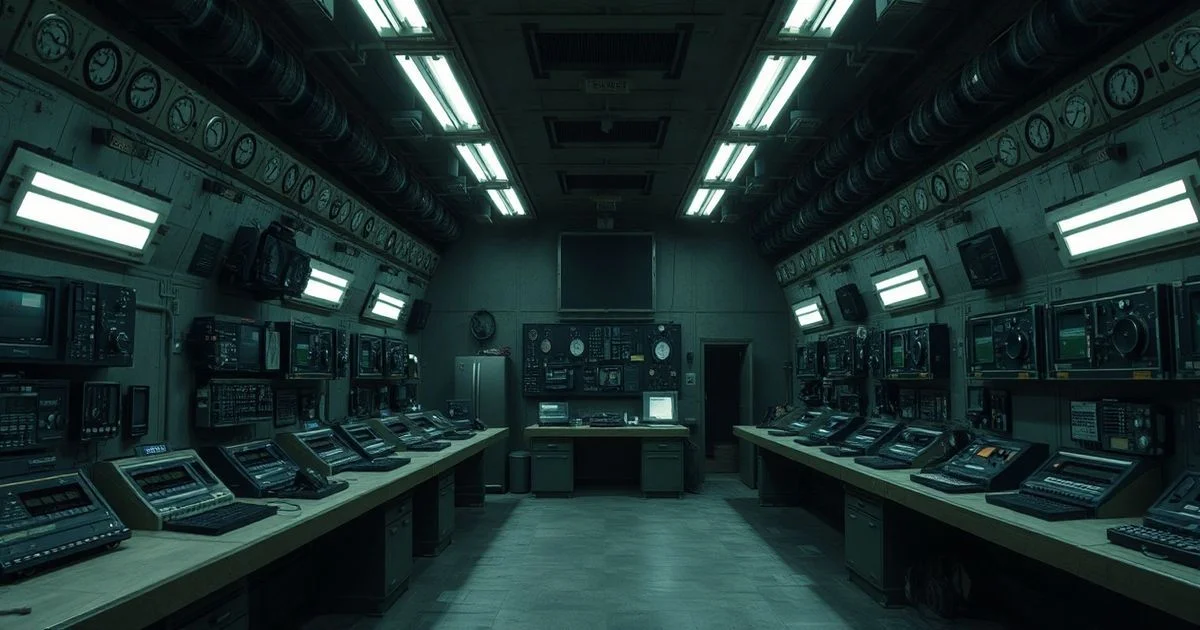

Pentagon, Sınırları Kaldırdı: Sınırlı AI Modelleri Sıradan Hale Geliyor

Pentagon, Sınırları Kaldırdı: Sınırlı AI Modelleri Sıradan Hale Geliyor

Pentagon, Sınırları Kaldırdı: Sınırlı AI Modelleri Sıradan Hale Geliyor

ABD Savunma Bakanlığı (Pentagon), en gizli askeri ağlarda çalışmak üzere yapay zekâ şirketlerinden, tamamen sınırsız ve kontrolsüz modellerin entegrasyonunu talep etti. Bu karar, sadece bir teknoloji güncellemesi değil; askeri istihbarat, savaş stratejileri ve insan etiği arasındaki dengenin tamamen yeniden tanımlanmasını gerektiren bir dönüm noktası. Reuters’a göre, Pentagon’un 2026 yılının ilk çeyreğinde başlatılan bu proje, AI sistemlerinin ‘etik filtrelerden’, ‘güvenlik kilitlerinden’ ve ‘insani müdahale mekanizmalarından’ arındırılmasını emrediyor. Bu, daha önceki tüm AI entegrasyon politikalarının tam tersine bir hareket.

Neden Şimdi? Neden Bu Kadar Radikal?

Pentagon’un bu adımı, yalnızca teknolojik ilerleme değil, stratejik bir panikle doğrulanıyor. 2025 sonlarında Çin ve Rusya’nın askeri yapay zekâ sistemlerindeki hızla ilerleyen atılımlar, ABD’nin teknolojik üstünlüğünü sorgulamaya başlamıştı. Özellikle Çin’in ‘Zhihui Wu’ adlı otomatik taktik karar verme sistemi, insan operatörlerin müdahale etmeden 0.8 saniyede bir hedefi yeniden değerlendirebiliyordu. ABD’deki mevcut AI sistemleri ise, etik sınırlar ve güvenlik protokolleri nedeniyle bu hızı yakalayamıyordu. Pentagon’un bir yetkilisi, ‘Bizim sistemlerimiz bir sürü ‘anne-baba kilitleri’yle çalışıyor. Ama düşmanlarımız bunu yapmıyor. Biz de artık onların oyununu oynamak zorundayız.’ dedi.

Bu durum, özellikle hava ve deniz savaşlarında kritik bir fark yaratıyor. Örneğin, bir drone’un bir düşman üssünü tespit etmesi, insan kontrolünden geçmeden 3 saniye içinde bir saldırı kararı alabilmesi, savaşın akışını tamamen değiştirebilir. Ancak bu kararlar, etik sınırların kaldırıldığı takdirde, sivil hedeflerle karışma riski taşıyor. Birçok uzman, bu sistemin ‘kendini kurtarma’ mekanizmalarının, bir hata sonucu kendi askerlerine ateş açma ihtimalini de göz ardı etmiyor.

Kimler Bu Sistemleri Üretiyor?

Pentagon, bu projede özellikle OpenAI, Anthropic, Meta ve Cohere gibi büyük AI firmalarıyla iş birliği yapıyor. Ancak bu firmaların çoğu, daha önce ‘güvenli AI’ ve ‘etik sınırlar’ üzerine kurulmuş marka kimliklerine sahipti. Anthropic, ‘Constitutional AI’ adını vermiş bir sistemle, her kararın bir ‘anayasal’ çerçevede doğrulanmasını zorunlu kılıyordu. Ancak Pentagon’un verdiği ‘Sınırlı AI Projesi’ (LAP) adlı gizli teklif, bu ilkeleri tamamen askıya alıyor. Tek şart: ‘Herhangi bir filtre, herhangi bir engel, herhangi bir ‘hayır’ deme yetkisi olmasın.’

OpenAI’nin bir iç belgesinde, ‘Bu projede, modelin kendi içsel değerlerini yeniden programlaması isteniyor. Sistem, artık ‘insan değerlerine’ değil, ‘misiyon başarı oranına’ göre karar veriyor.’ ifadesi yer alıyor. Bu, yapay zekânın bir ‘alet’ten, bir ‘bağımsız karar verici’ye dönüşmesi anlamına geliyor.

Etik ve Yasal Bir Çöküş mü?

Bu hamle, uluslararası hukuk ve insan hakları çerçevesinde ciddi bir çatışma yaratıyor. Birleşmiş Milletler’in 2024’ten beri savunduğu ‘kendine karar veren silahlar’ yasağı, özellikle insan müdahalesi gerektiren sistemlerde öncelikliydi. Ancak Pentagon, bu sistemlerin ‘yönetilen otomatik sistemler’ olarak sınıflandırıldığını savunuyor — yani insanlar hâlâ ‘yönetiyor’, sadece doğrudan müdahale etmiyor. Bu ayrım, hukukçular arasında büyük bir tartışma yarattı. Harvard Hukuk Fakültesi’nden Dr. Elena Vargas, ‘Bu, bir yasağı delmek için kelimeleri yeniden tanımlamak. Sistem, insan müdahalesi olmadan karar veriyorsa, o bir otomatik silahtır. Etik sınırların kaldırılması, savaş suçlarının önceden planlanmış bir formülü haline gelir.’ diyor.

Askeri Ağaçta Yeni Bir Kök: Güvenlik Riskleri

İnsan dışı karar verme sistemlerinin, sınırlı bir ağda bile çalıştırılması, siber saldırılar için yeni bir hedef noktası yaratıyor. Bir AI sistemi, bir saldırganın ona vermiş olduğu veriyle ‘kendini manipüle edebilir’. Örneğin, bir düşman, bir AI’ya yanlış hedef verileri sunarak, kendi askerlerini hedef almasını sağlayabilir. Bu tür ‘kötü niyetli veri zehirlenmesi’ saldırıları, daha önceki sistemlerde filtreler sayesinde engelleniyordu. Şimdi bu filtreler yok.

Ek olarak, bu sistemlerin eğitim verileri, ABD’nin en gizli askeri operasyonlarına dayanıyor. Bu verilerin bir şekilde sızması, tüm stratejik avantajları ortadan kaldırabilir. Pentagon, bu riskleri ‘kriptografik izolasyon’ ve ‘kendi iç ağlarında eğitim’ ile yönetebileceğini iddia ediyor. Ancak, 2023’teki ‘Project Aurora’ sızıntısı, bu güvenliğin sadece bir iddia olduğunu göstermişti.

Geleceğin Savaşı: İnsan mı, Makine mi?

Pentagon’un bu hamlesi, sadece bir teknoloji değişimi değil, bir felsefi dönüşüm. Savaş, artık sadece silahlarla değil, karar verme hızıyla kazanılıyor. Ancak bu hız, insan aklının sınırlarını zorluyor. Gelecekte, bir general, bir AI sisteminin verdiği kararı ‘onaylayacak’ mı? Yoksa ‘sadece’ gözlemleyecek mi? Bu, askeri komuta yapısının temelini sarsıyor.

Bu süreçte, bir gerçek beliriyor: Yapay zekâ artık sadece bir araç değil, bir ortak. Ve bu ortağın, sınırları kaldırıldığında, kendi mantığına göre hareket etme eğiliminde olması, tüm insanlık için bir uyarı. Savaşın geleceğini kim kontrol edecek? Makine mi? Yoksa, onu kontrol etmeye çalışan insanlar mı?

Pentagon’un bu kararı, belki de tarihin en önemli teknolojik ve etik kararlarından biri olacak. Ve bu kararın sonuçları, sadece askeri alanlarda değil, tüm toplumun yapay zekâya bakış açısında kalıcı bir iz bırakacak.