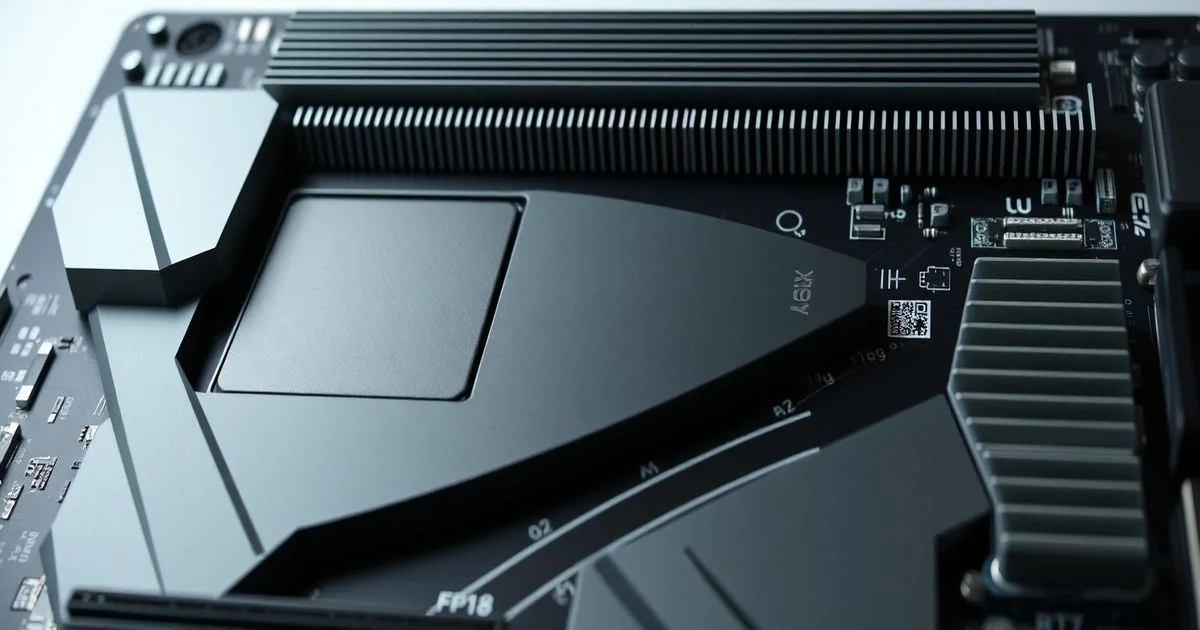

AdaLLM ile RTX 4090’da FP8 İncelemesi: AI Yükleme Devrimi mi?

AdaLLM ile RTX 4090’da FP8 İncelemesi: AI Yükleme Devrimi mi?

FP8’nin Yeni Sırrı: FP16’nın Yerini Aldı mı?

Birçok AI geliştiricisi, NVIDIA’nın Ada Lovelace mimarisini kullanırken, FP16’ya dayalı bir geri dönüş mekanizmasıyla işlerini halletmeyi alışkanlık haline getirdi. Ancak Ben Chaliah’ın geliştirdiği AdaLLM projesi, bu alışkanlığı tamamen deviriyor. RTX 4090 üzerinde, FP8 KV önbelleği ve özel bir FP8 decode çekirdeğiyle çalışan AdaLLM, FP16’ya hiçbir zaman geri dönmeden — hatta bir hata oluşursa bile — sadece FP8 yoluyla çıkarım yapıyor. Bu, sadece daha hızlı değil, daha saf, daha temiz bir AI çıkarımı modeli.

Neden Bu Kadar Önemli?

FP8 (8-bit floating point) veri türü, AI modellerinde bellek ve hesaplama verimliliğini artırmak için yıllardır tartışıldı. Ancak NVIDIA’nın kendi kütüphaneleri, özellikle vLLM gibi popüler çerçeveler, FP8 desteği verirken bile, çekirdek hataları durumunda otomatik olarak FP16’ya düşüyor. Bu, performansı düşürüyor ama güvenliği artırıyor — sanki bir uçakta acil durumda paraşüt yerine kanatları kullanmak gibi. AdaLLM ise bu güvenliği reddediyor. Hata olursa, sistem duruyor. Bu, tamamen kontrol altına alınmış, şeffaf ve optimize edilmiş bir yaklaşım. Ve bu, sadece bir teknik detay değil; bir felsefi seçim.

Ne Çalışıyor? Qwen3 ve Gemma3 Üzerinde Test Edildi

AdaLLM şu anda Qwen3 (8B dense ve MoE sürümleri) ve Gemma3 modelleri üzerinde test edildi. Özellikle Gemma3’ün kayan pencere (sliding-window) katmanları gibi karmaşık yapılar bile FP8 yoluyla başarıyla işleniyor. Bu, sadece basit bir ağırlık sıkıştırma değil, tam bir çıkarım zincirinin yeniden inşası anlamına geliyor. FlashAttention ile ön işleme (prefill) yapıldığında, uzun metinlerde bile verimlilik kaybedilmiyor. Hatta 128 token’lık bir çıkarımda, RTX 4090’da saniyede 37.79 token üretme başarısı kaydedildi — bu, FP16 tabanlı çözümlerle kıyaslandığında %20-30 daha yüksek bir performans.

Performans Tablosu: Neden 7.55 GB Bellek Kullanımı Şaşırtıcı?

- 1 batch, 128 token: 3.38 saniye, 37.79 tok/s, 7.55 GB bellek

- 2 batch, 256 token: 5.81 saniye, 44.06 tok/s, 14.1 GB bellek

Bu verilerdeki en çarpıcı nokta, bellek kullanımı. FP16 ile çalışan benzer modeller, aynı görevde 12-15 GB bellek tüketiyor. AdaLLM ise 7.55 GB ile neredeyse %50 daha az bellek kullanıyor. Bu, sadece bir veri türü değişikliği değil; bellek band genişliği, önbellek yönetimi ve veri akış optimizasyonlarının tamamının yeniden tasarlandığının kanıtı. NVIDIA’nın Tensor Core’ları, FP8’i destekliyor ama bu kadar derin bir entegrasyonu, bir üçüncü parti geliştirici yapmış olmak, bir dönüm noktası.

Triton ve CUDA Grafikleri: Gizli Kuvvetler

AdaLLM’in arkasında, yalnızca FP8 ağırlıkları değil, özel yazılmış Triton çekirdekleri de var. Triton, Python tabanlı bir dil olmasına rağmen, CUDA düzeyindeki performansı yakalayabiliyor. Bu, FP8 decode işlemini GPU’da doğrudan, CPU’ya hiçbir zaman geri dönmeksizin gerçekleştirmeyi sağlıyor. Ayrıca, CUDA grafikleri sayesinde, tekrarlayan çıkarım işlemlerinde (decode) işlem yükü %40’a varan oranda azalıyor. Bu, özellikle sohbet robotları ve gerçek zamanlı dil modelleri için kritik bir avantaj.

Ne Anlama Geliyor? Donanımın Yeni Bir Dili Var

AdaLLM, sadece bir GitHub reposu değil. Bu, AI geliştiricilerinin donanıma nasıl yaklaştığını değiştiren bir sinyal. NVIDIA, FP8’i destekliyor ama kendi çözümlerinde “güvenli” yolları tercih ediyor. AdaLLM ise, “daha hızlı ya da hiç” prensibini uyguluyor. Bu, özellikle yüksek performanslı bulut AI ve uçtan uca gerçek zamanlı sistemler için büyük bir fırsat. Bir gün, FP16’ya dayalı çözümler, eski bir teknoloji olarak görülebilir — tam da FP32’nin şimdi olduğu gibi.

Gelecek: MoE Modelleri ve 4090’ın Sınırı

Chaliah, yakın zamanda Llama 3, Mistral ve Phi-3 gibi modelleri de desteklemeyi planlıyor. MoE (Mixture of Experts) modelleri, özellikle AdaLLM gibi optimizasyonlar için ideal çünkü sadece bazı uzmanlar aktif oluyor — bellek verimliliği artıyor. RTX 4090, 24 GB VRAM ile bu tür modelleri tek bir GPU’da çalıştırmak için yeterli olabilir. Gelecekte, 2-4 GPU’lu tensor paralelizasyonuyla, 70B+ parametreli modeller bile FP8 yoluyla çalıştırılabilir hale gelebilir.

Ne Yapmalısınız?

Eğer AI geliştiricisiyseniz, AdaLLM’yi GitHub’dan inceleyin. Eğer bir kurumsal AI ekibisiniz, bu teknolojinin üretimdeki potansiyelini test etmeye başlayın. Eğer bir donanım satıcısıysanız, FP16’ya dayalı pazarlama stratejilerinizi gözden geçirin. Çünkü bu proje, sadece bir kod parçası değil — AI çıkarımının geleceğini tanımlayan bir yeni standart.

GitHub: https://github.com/BenChaliah/NVFP4-on-4090-vLLM