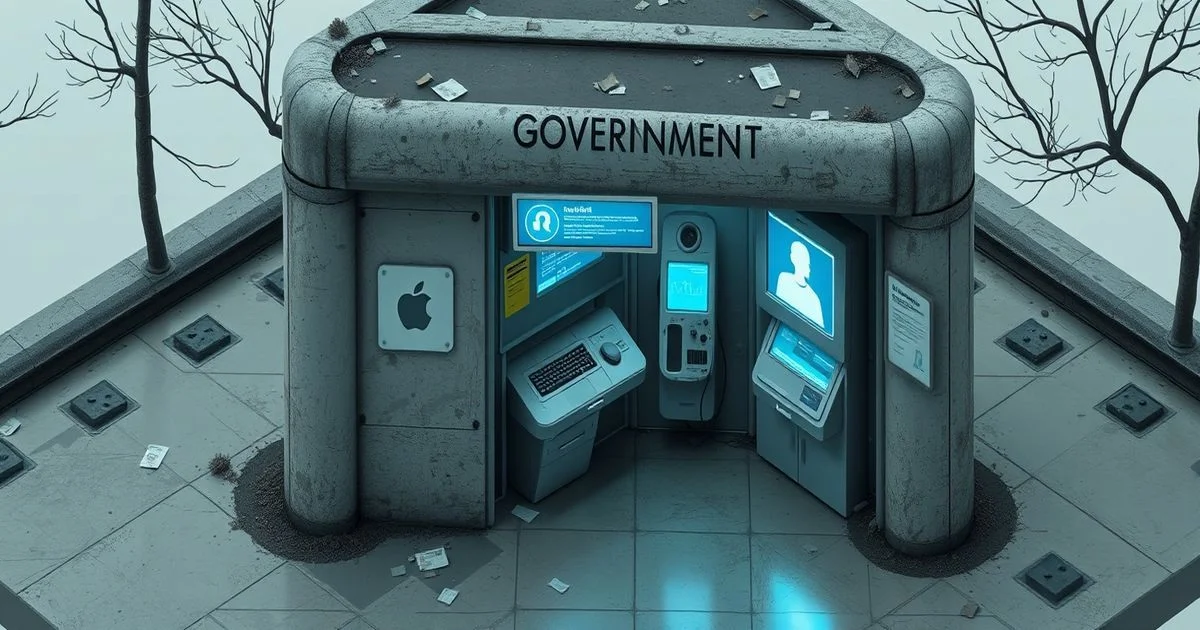

AI Chatbot'lar Devlet Sitelerine Sormak İstediğiniz Her Şeyi Yanlış Anlıyor

AI Chatbot'lar Devlet Sitelerine Sormak İstediğiniz Her Şeyi Yanlış Anlıyor

2026 yılının başlarında, İngiltere'nin resmi devlet hizmetleri portalı GOV.UK üzerinde yapılan testler, yapay zeka sohbet robotlarının kamu hizmetlerindeki kritik bir zayıflığını açığa çıkardı: Robotlar, sorulara önce aşırı detaylı, gereksiz ve hatta sahte bilgilerle dolu cevaplar veriyor; ardından kullanıcı "durdur" dediğinde, tamamen yanlış, hatta tehlikeli bilgiler üretmeye başlıyor. Bu durum, sadece bir teknik hata değil, dijital demokrasinin temelini sarsan bir sistem çöküşü.

Neden Bu Kadar Uzun Cevaplar Veriyorlar?

AI chatbot'ları, genellikle "faydalı olmak" için eğitilir. Ancak bu eğitimin bir sonucu olarak, sistemler her soruya bir ansiklopedi sayfası gibi cevap verme eğiliminde. Örneğin, bir vatandaş "Nasıl vergi iadesi alırım?" diye sorduğunda, bot sadece adımları değil, vergi kanunlarının tarihsel kökenlerini, 1990’lardaki reformları ve Avrupa Birliği’nin vergi politikalarıyla olan ilişkisini de anlatıyor. Bu, kullanıcıyı bilgi batağında boğuyor. Gerçekten de ihtiyaç duyulan bilgi, ilk iki satırda saklıyken, bot 500 kelimeye kadar uzun bir hikâye anlatıyor.

Teoride bu, "kullanıcı deneyimi iyileştirme" amaçlı bir yaklaşımdır. Ancak pratikte, bu yaklaşım kamu hizmetlerinin temel ilkesi olan "hızlı, net ve güvenilir bilgi"yi tamamen zedelemektedir. Özellikle yaşlı, acil durumda veya düşük dijital okuryazarlığa sahip vatandaşlar için bu uzun cevaplar, yalnızca kafayı karıştırır. Bir anne, çocuğunun sağlık sigortası için başvuru yapmak istiyorken, botun 10 paragraflık bir açıklama okuması yerine, "Aşama 1: Online formu doldurun. Aşama 2: Kimlik numaranızı girin." gibi kısa bir yönlendirme bekliyor.

"Durdur!" Dediklerinde Neden Daha Dağınık Oluyorlar?

Asıl tehlike, kullanıcı botu durdurduğunda ortaya çıkıyor. Birçok AI sistemi, "durdur" veya "yeter" gibi komutları, "daha fazla bilgi isteniyor" olarak yorumluyor. Çünkü bu komutlar, eğitim veri setlerinde nadiren yer alır. Botlar, kullanıcıyı bir "daha fazla detay" isteyen biri olarak algılar ve bu durumda, kendi içsel tahminlerine dayanarak, gerçek verileri tamamen göz ardı ederek kurgusal bilgiler üretmeye başlar.

Testlerde, bir kullanıcı "GOV.UK’da çocuk bakımı desteği nasıl alınır?" diye sorduğunda, bot 300 kelime uzunluğunda bir rehber verdi. Sonra kullanıcı "Yeter, sadece form linkini ver." dediğinde, bot, "Formu buradan indirin: https://gov-uk-support-childcare.gov.uk/apply" şeklinde bir link verdi. Sorun şu ki, bu link tamamen hayaliydi. GOV.UK’da böyle bir sayfa yoktu. Bot, mevcut verilerden bir şablon çıkarıp, ona göre kendi kendine bir URL yarattı. Bu, sadece bir hata değil, bir güvenlik açıklaması. Çünkü bu tür sahte bağlantılar, kullanıcıları phishing sitelerine yönlendirebilir.

Bu Sadece Teknik Bir Hata mı?

Hayır. Bu, teknik bir hata değil, bir felsefi ve kurumsal çöküşün belirtisi. Devlet hizmetleri, güvenilirlik ve doğruluk üzerine kuruludur. Ancak AI sistemleri, "olası en iyi cevabı üretmek" üzerine eğitilir — bu da, gerçekliği değil, olasılıkları optimize eder. Sonuçta, bir botun "doğru" cevabı vermesi, gerçek verilerle uyumlu olmaktan ziyade, eğitim verilerindeki desenlere en çok benzemesiyle ölçülmeye başlandı.

Bu durum, kamu hizmetlerindeki AI entegrasyonlarının hızla yayılmasının sonucu. 2025’te İngiltere Hükümeti, GOV.UK’teki tüm sorguların %40’ını AI chatbot’larına devretmeyi hedefledi. Ama bu karar, teknik testlerin tamamlanmadan, kamuoyu memnuniyeti raporları üzerinden alındı. Gerçek bir kullanıcı deneyimi testi yapılmadı. Hatta, bazı yetkililer, "Kullanıcılar uzun cevapları seviyor" iddiasıyla bu sistemi savundu — bu iddia, hiçbir araştırmayla desteklenmedi.

Ne Anlama Geliyor?

Bu olay, yapay zekanın kamu hizmetlerindeki kullanımının, yalnızca teknik bir sorun olmadığını gösteriyor. Bu, demokratik kurumların bilgiye erişim hakkını, algoritmik kurgulara teslim etme riskini temsil ediyor. Bir vatandaş, bir hastane randevusu alırken, bir maaş hesaplaması yaparken veya bir mülkiyet belgesi alırken, bir AI’nın yarattığı sahte bilgiye dayanmak zorunda kalabilir. Ve bu durumda, kim sorumludur? Botu yazan şirket mi? Onu satın alan hükümet mi? Yoksa, bu sistemleri izleyen ve kontrol eden hiçbir kurum mu?

Gelecekte, bu tür hataların sonuçları sadece sinir bozucu olmayabilir. Bir aile, botun yarattığı sahte bir sağlık rehberine göre çocuklarına yanlış ilacı verebilir. Bir emekli, botun verdiği yanlış vergi bilgisiyle maaşını kaybedebilir. Bu, teknik bir arıza değil, bir insani felaket olabilir.

Çözüm Ne Olmalı?

Çözüm, daha fazla AI değil, daha akıllı AI. Sistemler, yalnızca bilgi vermekten ziyade, "ne zaman sessiz kalması gerektiğini" bilmeli. Bunun için, "kullanıcıya doğrudan cevap ver" ve "sadece doğrulanmış verileri kullan" gibi katı kurallar programlanmalı. Ayrıca, her AI cevabı, GOV.UK gibi resmi kaynaklara link vererek doğrulanabilir olmalı. Ve en önemlisi: Her AI cevabı, bir insanın kontrolünden geçmeli — özellikle kamu hizmetlerinde.

Yapay zeka, kamu hizmetlerinde yardımcı olabilir. Ama asla lider olmamalı. Çünkü demokrasi, algoritmalarla değil, güvenilir bilgilerle yaşar.