MiniMax-M2.5, 192GB VRAM ile 416 token/saniye: Yeni Hybrid AWQ Quant ile AI sırları çözüldü

MiniMax-M2.5, 192GB VRAM ile 416 token/saniye: Yeni Hybrid AWQ Quant ile AI sırları çözüldü

AI Modellemede Bir Devrim: 229 Milyar Parametreli MiniMax-M2.5, 192GB VRAM’da Neden Kâhretti?

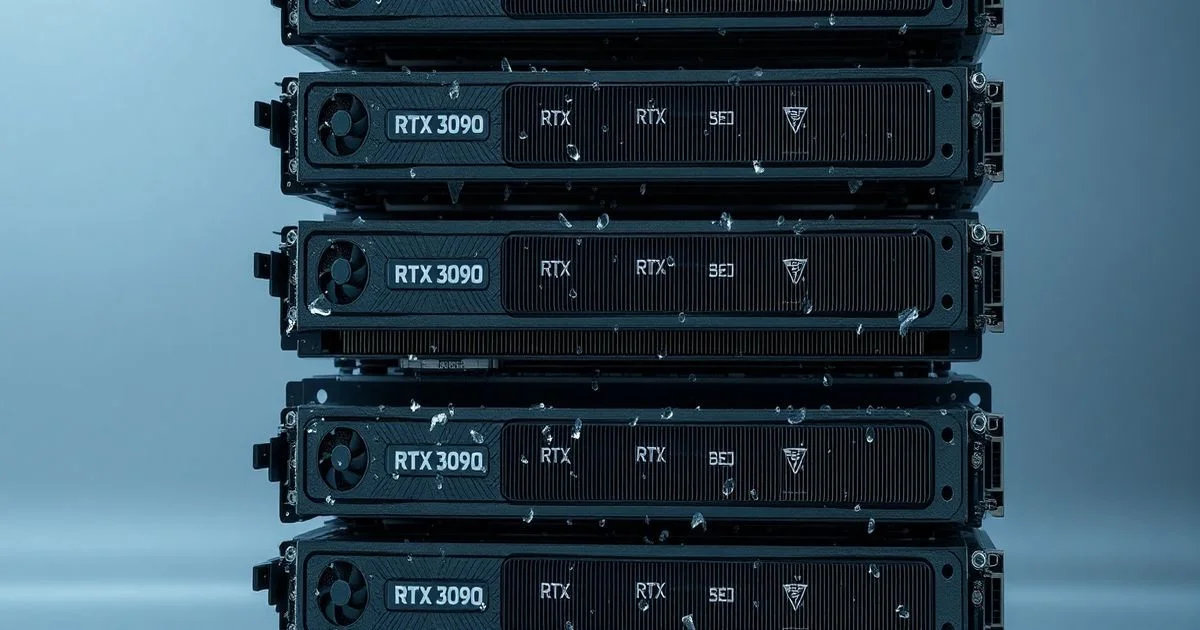

Geçtiğimiz hafta, Reddit’te bir AI araştırmacısı, yapay zekâ dünyasını sarsan bir paylaşım yaptı. 229 milyar parametreli MiniMax-M2.5 adlı devasa dil modeli, geleneksel yöntemlerle 8x RTX 3090 veya 4x RTX A6000 gibi 192GB VRAM’a sahip sistemlerde bile sadece bir tek istekle bile yeterli bellek bulamıyordu. Ama şimdi? Aynı donanımda 16 istek aynı anda işleniyor, saniyede 416 token üretiyor — bu, önceki sınırların neredeyse iki katı. Ne değişti? Ne keşfedildi? Ve neden bu, sadece bir teknik iyileştirme değil, bir felsefe değişikliği?

Ne Yapıldı? Hybrid AWQ Quant: Sadece Bir Quantizasyon Değil, Bir Simfoni

Yeni teknik, adını “Hybrid AWQ Quant” alan bir kombinasyondan geliyor. Bu, sadece ağırlıkları 4-bit’e indirmekle kalmıyor; aynı zamanda dikkat mekanizmalarını (attention) ve önbellek verilerini (KV cache) tamamen farklı bir mantıkla yeniden tasarlıyor. Burada üç katman var:

- Expert MLP’ler (224.7B parametre): AWQ ile 4-bit tam olarak quantize edildi — bu, ağırlık boyutunu %75 oranında azaltıyor ama doğruluğu koruyor.

- Attention mekanizmaları (2.7B parametre): Bu küçük ama kritik bölüm, FP8_e4m3 presizyonunda kalıyor. Neden? Çünkü dikkat matrisleri, hesaplama yoğunluğu yüksek ve hassas; bu bölümde kayıplar, çıktı kalitesini bozuyor.

- KV önbelleği (runtime): Burada en parlak buluş var: Her katman için ayrı ayrı kalibre edilmiş FP8_e4m3 önbelleği. Bu, önceki sistemlerdeki sabit ölçeklendirmeleri yerine, dinamik ve katman-spesifik veri yoğunluğuna göre bellek kullanımını optimize ediyor.

Bu üç bileşenin bir araya gelmesi, vLLM gibi popüler inference çerçevelerinin desteklememesi nedeniyle yıllarca yapılamadı. Kullanıcılar, AWQ ile bellek tasarrufu yaparken attention’ı FP16’da bırakmak zorunda kalıyordu — bu da KV cache’i patlatıyordu. Ya da FP8 attention kullanırken, ağırlıkları tam olarak quantize edemiyorlardı. Bu araştırmacı, bu iki dünya arasında bir köprü kurdu.

Neden Bu Kadar Önemli? Batching’deki Devrim

AI modelleri için en büyük engel, tek istekle sınırlı kalınmasıdır. Bir model, 8000 token’lık bir bağlamda çalışırken, KV cache’i 160K token’a kadar ulaşabiliyordu — yani sadece birkaç kullanıcıya hizmet verebiliyordu. Bu yeni yöntemle, aynı donanımda 370.000 token’lık KV önbelleği tutulabiliyor. Bu, aynı anda 16 kullanıcıya hizmet vermenin mümkün olduğunu gösteriyor — ve hatta daha fazlasına.

Yani, bir AI servisi artık 16 farklı müşteriye aynı anda yanıt veriyor. Bunu yaparken saniyede 416 token üretiyor. Bu, geleneksel AWQ ile yapılan bir sistemin yaklaşık %160 daha yüksek throughput’u demek. Bu, işletmeler için maliyetlerde %50’ye varan düşüş anlamına geliyor. Cloud’da daha az GPU, daha fazla kullanıcı — bu, AI hizmetlerinin ticari olarak sürdürülebilirliğini tamamen değiştiriyor.

Ne Anlama Geliyor? AI’nın “Enerji Verimliliği” Yeni Sınırları

Bu teknik, sadece bir “hile” değil. AI modellemede bir paradigma değişikliği. Daha önce, her bileşen için tek bir presizyon seçiliyordu — ya FP16, ya INT4. Ama gerçek dünya sistemleri, farklı bileşenlerin farklı hassasiyetlere ihtiyaç duyduğu karmaşık makineler. Bu, bir araba motorunun benzinle çalışırken, frenlerinin hidrolikle çalıştığı gibi. Hybrid AWQ, bu düşünceyi ilk kez pratikte uyguladı.

Özellikle, KV cache’in kalibre edilmesi, 2025’e kadar AI veri merkezlerindeki bellek yönetimi standartlarını değiştirecek. Şu ana kadar, önbellek verileri “tamamen FP16” ya da “tamamen INT8” olarak tutuluyordu. Bu, gereksiz yerlerde bellek harcamaya neden oluyordu. Kalibreli FP8, sadece gerekli olan yerde hassasiyeti koruyarak, %40’a varan bellek tasarrufu sağlıyor.

Gelecek Ne Getiriyor? 1 Trilyon Parametreli Modeller İçin Kapı Açıldı

MiniMax-M2.5 229B’lik. Ama bir sonraki nesil model 500B, hatta 1T olacak. Bu teknik, bu modellerin 8x A100 gibi 192GB’lık sistemlerde bile çalıştırılmasını mümkün kılıyor. Aksi takdirde, 1T’lik bir modelin çalıştırılması için 16x A100 (1.5TB VRAM) gerekecekti — ki bu, maliyet olarak 5 milyon doları aşar. Hybrid AWQ, bu maliyeti 1.5 milyon dolara düşürebilir.

Artık, AI modelleri sadece Google, Meta veya OpenAI gibi devlerin elinde değil. Küçük AI startup’lar, kendi 4-8 GPU’luk sistemlerinde, 100B+ parametreli modelleri verimli şekilde çalıştırmaya başlayabilir. Bu, AI demokratizasyonunun yeni bir aşaması.

Yeni model, Hugging Face’te açık kaynak olarak paylaşıldı. Bu, sadece bir teknik paylaşım değil — bir çağrı. “Bunu kendi sistemlerinize entegre edin. Geliştirin. Daha iyisini yapın.”

AI dünyasında, büyüklerin sadece büyük modelleri değil, aynı zamanda büyük çözümleri de üretmesi gerekir. Bu araştırmacı, küçük bir ekiple, büyük bir problemi çözdü. Ve bu, geleceğin nasıl yazılacağını gösteriyor.