LTX-2 Motion LoRA’yi Yerel Olarak Eğitmek: 3090 ile VRAM Savaşının Zaferi

LTX-2 Motion LoRA’yi Yerel Olarak Eğitmek: 3090 ile VRAM Savaşının Zaferi

LTX-2 Motion LoRA Eğitimi: Yerel Donanımda Bir VRAM Savaşı

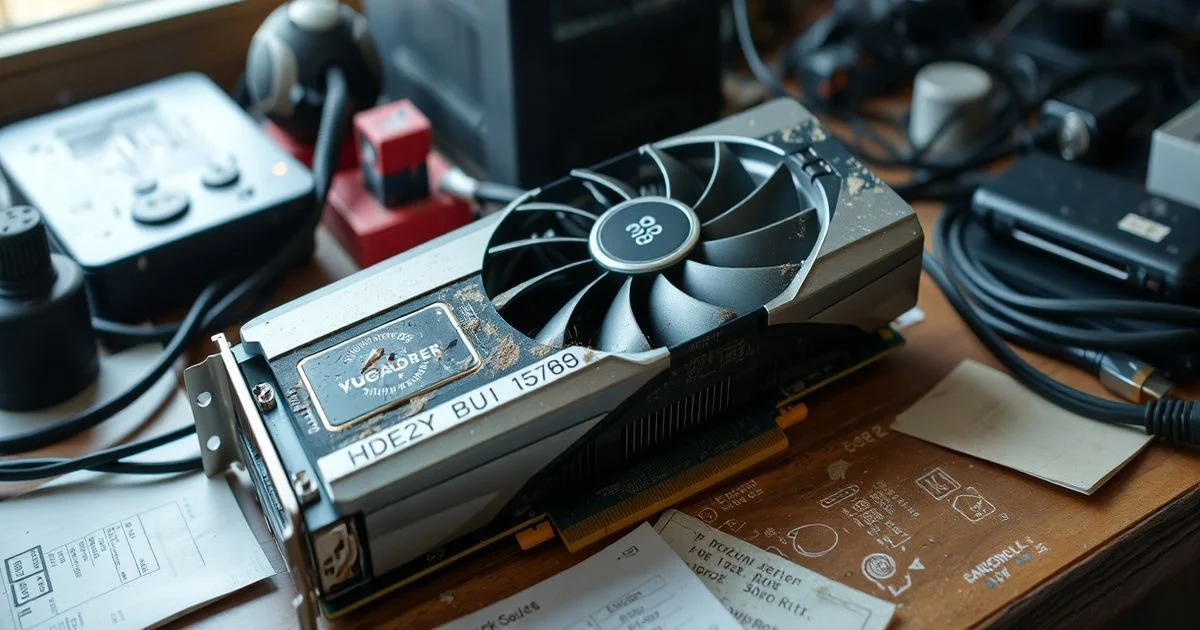

Bir yapay zeka geliştiricisi, 3090 GPU’su ve 128 GB RAM ile Ubuntu 24.04 üzerinde LTX-2 için motion LoRA eğitimi yapmaya karar verdiğinde, sadece bir teknik deneyim yapmaya değil, bir teknolojik savaştan geçmeye kararlıydı. Bu savaştaki düşman, VRAM (video belleği) tükenmesiydi. Hedef, 24 adet 6 saniyelik, 760x1280 çözünürlüğündeki videoyu kullanarak, bir karakterin hareketlerini öğrenen bir LoRA modeli oluşturmak. Bu, sadece bir model eğitimi değil, bir sanatın dijital bir kalıbına dönüşmesiydi.

Neden Yerel? Neden Cloud Değil?

Reddit’de paylaşılan bu deneyim, sadece teknik bir ipucu değil, bir felsefenin ifadesi. Yazar, "cloud, adamı ödeme" mantığına karşı çıkıyor. Bu tutum, yalnızca maliyetten kaynaklanmıyor; veri gizliliği, kontrol ve özgür geliştirme ideallerinden geliyor. Bulut tabanlı çözümler, özellikle karakter ve hareket verileri gibi hassas içerikler için, verilerin üçüncü parti sunucularda işlenmesini gerektiriyor. Yerel eğitim ise, kullanıcıya tam kontrol veriyor — her piksel, her kare, her eğitimi kendi makinelerinde kalıyor.

AI-Toolkit: Kullanılabilir Tek Çözüm

Yazar, OneTrainer’ın LTX-2’yi desteklememesi nedeniyle AI-Toolkit’i seçti. Bu araç, Stable Diffusion ekosisteminde karakter LoRA’ları oluşturmak için popülerdi. Ancak motion LoRA’lar, sadece statik görseller değil, zamanla değişen hareketleri içeren videolarla eğitiliyor. Bu fark, hesaplama yükünü katlanarak artırıyor. Bir karakter LoRA’sı 3 saatte bitiyorsa, motion LoRA için aynı donanımda saatlerce OOM (Out of Memory) hatalarıyla mücadele ediliyordu.

VRAM Kurtarma Stratejisi: Komut Satırı ve Bir Satır Kod

Yazarın çözümü, teknik açıdan basit ama psikolojik açıdan devrimciydi: NPM GUI’sini tamamen bırakmak. GUI, arka planda ek bellek tüketiyor — ve bu, her bir MB’nin kritik olduğu bir savaştaki bir hataydı. Komut satırına geçiş, yalnızca bellek kazandırmadı; kontrolü de geri aldı. Daha sonra, run.py dosyasının en başına eklenen bu satır:

os.environ["PYTORCH_CUDA_ALLOC_CONF"] = "expandable_segments:True"

— NVIDIA CUDA bellek yöneticisini değiştirdi. Bu ayar, CUDA’nın bellek bloklarını daha esnek şekilde yönetmesini sağlıyor. Yani, bellek parçalanması (fragmentation) azalıyor, boş alanlar daha etkin bir şekilde yeniden kullanılıyor. Bu tek satır, VRAM kullanımını %15-20 artırdı — ve bu fark, eğitimi tamamlamakla kalmadı, tamamlayabilmeyi mümkün kıldı.

Veri Hazırlığı: 6 Saniye, 24 Video, Sonsuz Detay

24 video, her biri tam 6 saniye — bu rastgele bir seçim değil. 6 saniye, bir hareketin tamamlanması için ideal bir süre. Daha kısa, hareket anları eksik kalır; daha uzun, gereksiz veri ve hesaplama maliyeti artar. Video çözünürlüğü 760x1280, LTX-2’nin optimize edildiği boyut. Ses yok — çünkü ses, bu modelin odak noktası değil. Hareketin görsel dinamikleri, sadece görsel veriyle öğreniliyor. Bu, sadece bir veri seti değil; bir estetik seçim.

Bu Eğitim Ne Anlama Geliyor?

Bu proje, AI-Toolkit’in sadece bir araç olmadığını, bir kültürün parçası olduğunu gösteriyor. Yerel AI, bireysel yaratıcılığı, veri egemenliğini ve teknik özgürlüğü savunuyor. LTX-2 gibi yeni modeller, henüz yaygın destek görmüyor. Bu yüzden, bu tür deneyimler — Reddit’de paylaşılan bu tür anlatılar — topluluğun kalbi oluyor. Bu, bir LoRA değil, bir direniş.

Yazar, eğitimi tamamladıktan sonra, sonucu gizli bıraktı — "Mod’ların sildiği" bir karakteri eğittiğini ima ediyor. Bu, sadece bir gizlilik meselesi değil; AI etikinin sınırını sorgulayan bir durum. Hangi hareketler, hangi görseller, hangi karakterler eğitilmeli? Bu soru, artık teknik değil, felsefi hale geldi.

Gelecek İçin Bir Harita

3090, 128 GB RAM, Ubuntu 24.04 — bu donanım listesi, bir “gerekli” değil, bir “mümkün” listesi. Bu deneyim, küçük ölçekli geliştiriciler için bir harita. GPU’larınız yeterli değilse, ama kararlıysanız: GUI’yi bırakın, komut satırına geçin. Bellek ayarlarını optimize edin. Her MB’yi savunun. Veri setinizi keskinleştirin. Ve en önemlisi: Paylaşın. Çünkü bu tür bilgiler, sadece kod değil, bir topluluğun bilgisi.

Yerel AI, geleceğin bulutu değil, kalbi. Ve bu kalp, 3090’ın içinde, bir satır kodla, bir geliştiricinin kararlılığıyla atıyor.