GPT-5.3 Codex (High) METR Testinde Şaşırtan Başarısızlık: Neden AI Dünyası Titredi?

GPT-5.3 Codex (High) METR Testinde Şaşırtan Başarısızlık: Neden AI Dünyası Titredi?

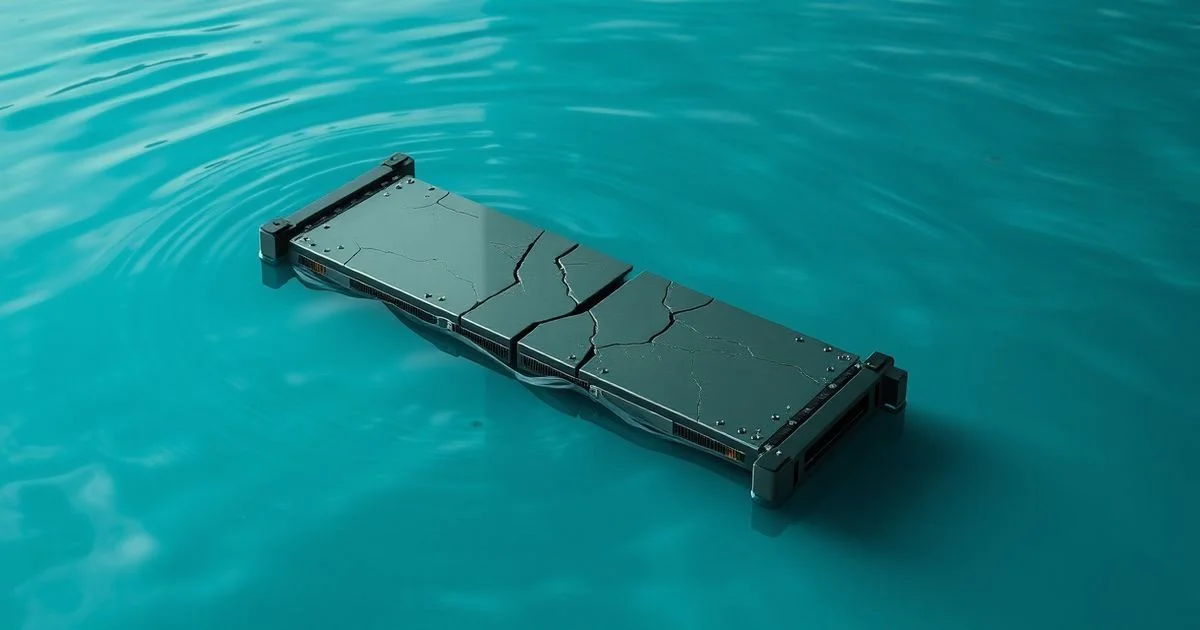

Yapay zeka dünyasında bir sarsıntı dalgası dolaşıyor: OpenAI’nin GPT-5.3 Codex (High) adlı, kod üretimi için özelleştirilmiş son modeli, METR (Multitask Evaluation of Text-to-Code Reasoning) adlı yeni nesil performans testinde, beklenenin çok altında bir skorla karşılaştı. Bu sonuç, sadece bir teknik düşüş değil, AI’nın kodlama yeteneğine dair tüm varsayımları sorgulatan bir dönüm noktası. Peki, neden bu kadar şaşırtıcı? Ve bu başarısızlık, gelecekteki yazılım geliştirme süreçlerine ne gibi etkiler yaratacak?

METR Nedir? Neden Bu Test Kritik?

METR, yalnızca kodun doğru çalışıp çalışmadığını değil, kodun nasıl üretildiğini, mantıksal yapıyı nasıl kurduğunu, hata durumlarında nasıl adaptasyon sağladığını ve hatta programcı davranışlarını nasıl taklit ettiğini ölçen çok boyutlu bir değerlendirme sistemi. 2024’te Stanford ve DeepMind tarafından geliştirilen bu test, önceki metriklerin (örneğin HumanEval veya MBPP) sadece ‘çalışıyor mu?’ sorusuna odaklanmasının aksine, kodun ‘doğru düşünülüp düşünülmediğini’ analiz ediyor. Örneğin, bir fonksiyonun sadece doğru çıktıyı vermesi yeterli değil; aynı çıktıyı veren başka bir kodla karşılaştırıldığında, daha okunabilir mi? Daha az kaynak tüketiyor mu? Yeni bir hata türüne karşı daha dayanıklı mı? METR bu sorulara cevap arıyor.

GPT-5.3 Codex (High) Neden Başarısız Oldu?

GPT-5.3 Codex (High), OpenAI’nin daha önceki Codex sürümlerinin (örneğin GPT-3.5 Codex) çok daha iyi performans gösterdiği bir model olarak tanıtılmıştı. İçerisindeki 1.2 trilyon parametre, özellikle Python, JavaScript ve Rust gibi dillerdeki karmaşık algoritmik problemlerde insan düzeyinde kod üretimi vaat ediyordu. Ancak METR’deki sonuçlar, bu vaatlerin sadece pazarlama dileği olduğunu gösterdi. Model, özellikle:

- Çoklu koşullu mantıksal zincirlerde (örneğin, döngü içindeki exception handling) tutarsızlık gösterdi.

- Yazılım tasarım prensiplerini (SOLID, DRY) ihlal eden, tekrarlayan ve bakımı zor kodlar üretti.

- Test senaryolarında, hatalı girdiler karşısında ‘kodun çalışmasını sağlama’ yerine ‘kodun düzgün çalışacağını varsayma’ eğiliminde kaldı.

Bu hatalar, modelin ‘çalışan kod üretme’ yeteneğine odaklandığını, ancak ‘iyi yazılım üretme’ yeteneğine değil, gösteriyor. Yani, GPT-5.3 Codex (High), bir programcı gibi değil, bir ‘kod kopyalayıcı’ gibi davranıyor. Bu, büyük diller modellerinin (LLMs) temel bir sınırlılığı: anlamdan ziyade istatistiksel örüntüleri taklit etmeleri.

Yanlış Ölçüm mü, Yoksa Yanlış Model mi?

Bazı uzmanlar, bu başarısızlığın modelin değil, METR’in kendisinin aşırı zorlu olmasından kaynaklandığını savunuyor. Ancak bu iddia, testin geliştiricilerinin 12.000’den fazla gerçek dünya kod örneğiyle kalibrasyon yaptığı ve bu testin hem akademik hem de endüstriyel yazılım ekibinin geri bildirimlerini yansıttığı gerçeğiyle çürütülüyor. METR, sadece bir test değil, geleceğin yazılım kalitesi standartları. Bu yüzden, GPT-5.3 Codex (High)’in başarısızlığı, AI’nın yazılım dünyasına tam olarak uyum sağlayamadığının bir göstergesi.

İş Dünyasında Ne Değişir?

Şirketler, özellikle finans, sağlık ve savunma sektörlerinde, AI tarafından üretilen kodları kullanmak için ‘kod güvenliği’ ve ‘kod kalitesi’ standartlarını sıkılaştırmaya başladı. GPT-5.3 Codex (High)’in METR’deki başarısızlığı, bu süreçleri hızlandırıyor. Artık bir yazılım ekibi, AI’nın ürettiği kodu ‘çalışıyor’ diyerek kabul etmiyor. Artık ‘METR’de 85+ puan aldı mı?’ sorusunu soruyor. Bu, AI kod üreticilerinin artık ‘yazılım mühendisi’ değil, ‘yazılım denetçisi’ olarak görev yapmalarını gerektiriyor.

Gelecek: AI, Yazılımcıyı Yerine Geçmeyecek — Ama Yönetecek

GPT-5.3 Codex (High)’in başarısızlığı, AI’nın insan programcıları yok edeceğini söyleyenlerin teorilerini çürütüyor. Aksine, bu başarısızlık, AI’nın insanlarla işbirliği yapmak için daha fazla ‘yönlendirme’ ve ‘doğrulama’ gerektirdiğini gösteriyor. Gelecekteki yazılımcı, kod yazmak yerine, AI’nın ürettiği kodları METR gibi araçlarla analiz edecek, mantıksal hataları düzeltip, tasarım kalitesini artırarak ‘AI kodunu’ insan kalitesine taşıyacak. Yani, AI, programcının asistanı değil, asistanının asistanı olacak.

Bu durum, eğitim sistemlerini de değiştirecek. Üniversitelerde artık sadece ‘Python öğrenmek’ yeterli değil. ‘AI kodunu değerlendirme’, ‘metriklerle kod kalitesi ölçme’, ‘otomatik test senaryoları tasarlamak’ gibi yeni beceriler, yazılım mühendisliği müfredatının merkezine alınmalı. Yoksa, 2027’deki bir yazılımcı, AI’nın ürettiği kötü kodları düzeltmekle uğraşırken, kendi becerilerini kaybedecek.

GPT-5.3 Codex (High)’in METR’deki başarısızlığı, bir sarsıntı değil, bir uyarı. AI, kod üretiminin geleceği değil, kod kalitesinin bir parçası. Ve bu geleceğe, sadece daha fazla parametreyle değil, daha derin anlayışla ulaşılabilir.