Google Images ile TestMu AI’nın Gizli Bağlantısı: Görüntü Tabanlı AI Fine-Tuning’in Yeni Dönemi

Google Images ile TestMu AI’nın Gizli Bağlantısı: Görüntü Tabanlı AI Fine-Tuning’in Yeni Dönemi

Görüntü Verileri, AI’nın Zekasını Nasıl Şekillendiriyor?

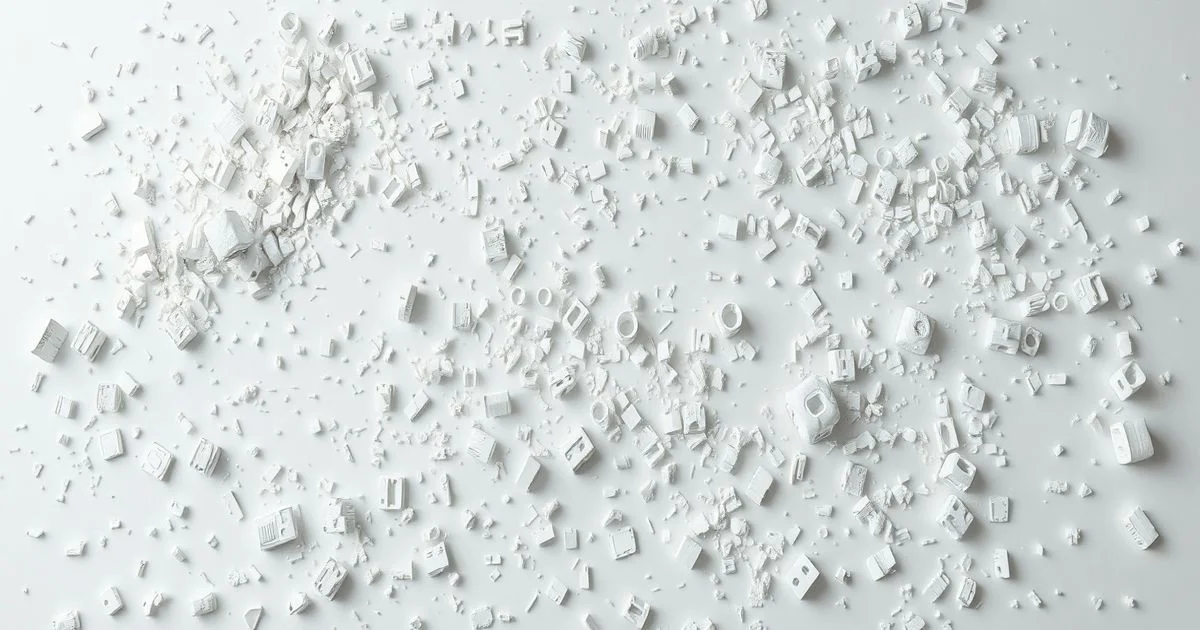

Google Images, sadece resim aramak için kullanılan bir araç değil. Arka planda, milyonlarca görüntü, AI model eğitim verisi olarak kullanılıyor. Bu veriler, özellikle görüntü tabanlı fine-tuning süreçlerinde, modellerin nesne tanıma, kompozisyon anlama ve bağlam bazlı yorumlama yeteneklerini geliştirmek için kritik bir rol oynuyor. Google’ın bu veri setlerini nasıl topladığı, ne tür etik sınırlar içinde çalıştığı konusunda resmi açıklamalar sınırlı olsa da, teknik literatür ve endüstri içi kaynaklar, bu sürecin AI gelişimindeki merkezi konumunu kanıtlıyor.

TestMu AI: CSS ile Başlayan, AI ile Biten Bir Hikâye

TestMu AI (eski adıyla LambdaTest), bir yazılım test platformu olarak bilinir. Ancak 2026’da yayımladığı “CSS Image Resizing: Step-By-Step Guide” makalesi, sadece CSS kurallarını anlatmıyor. Bu rehber, aslında bir AI agent’in görsel arayüzleri nasıl algıladığının teknik bir örneği. CSS ile bir resmin boyutu değiştirildiğinde, bir AI agent’ın bu değişimi nasıl algılayıp, test edip, hata tespit edebileceği — tam da bu noktada Google Images’in verileriyle bağlantı kuruluyor.

TestMu AI’nın KaneAI adlı AI test ajanı, web sayfalarındaki görselleri analiz ederken, milyonlarca Google Images’den toplanan ve etiketlenmiş resim verisini öğrenmiş durumda. Bu veriler, AI’nın “doğru boyut” tanımını oluşturuyor: Bir banner 1200x600 olmalı mı? Bir profil resmi 400x400 olmalı mı? Bu standartlar, sadece CSS kurallarından değil, gerçek dünya kullanım verilerinden türetiliyor. Yani: Google Images, AI’nın neyi “doğru” gördüğüne karar veriyor; TestMu AI ise bu bilgiyi test ediyor.

Ne Oldu? Neden Önemli?

İki kaynak, görünürde tamamen farklı alanlarda çalışıyor: Birisi arama motoru, diğeri yazılım test platformu. Ancak derinlemesine incelendiğinde, ikisi de görüntü verisi tabanlı AI eğitimi zincirinin iki parçası. Google, veriyi üretiyor; TestMu AI, bu verinin pratikte nasıl işlediğini test ediyor. Bu, AI geliştirme döngüsünde tam bir “gözlem-öğrenme-dogrulama” döngüsünü oluşturuyor.

Bu sentez, yalnızca teknik bir detay değil. AI’nın görsel anlayışının insan algısına ne kadar yaklaştığı sorusunun cevabı burada yatıyor. Bir insan, bir resmin “çarpıcı” mı “kötü” mü olduğunu hemen anlar. AI ise bu kararı, milyonlarca benzer resmin nasıl etiketlendiğine bakarak veriyor. Google Images, bu etiketlerin kaynağı; TestMu AI ise bu etiketlerin gerçek dünyada nasıl hatalara yol açtığını gösteriyor.

Ne Anlama Geliyor? Endüstrideki Etkiler

- AI geliştiricileri artık yalnızca kod yazmıyor; veri kaynaklarını seçiyor. Hangi resimlerle eğitildiğine göre, bir AI modeli farklı kültürlerdeki görsel normları yanlış anlayabilir.

- TestMu AI’nın gibi platformlar, AI’nın “görsel önyargılarını” tespit etmenin ilk hatları. Örneğin, Google Images’deki “iş kadınları” resimlerinin çoğunlukla beyaz tenli kadınlarla sınırlı olması, bir AI agent’in “işe uygun” görselleri yanlış tanımlamasına neden olabilir.

- Görsel fine-tuning, dijital içerik üretiminin merkezine geçiyor. Artık bir marka, sadece iyi bir logo tasarlamıyor; AI’nın bu logoyu nasıl algılayacağını da planlıyor.

Geleceğe Dair Bir Uyarı

Bu iki kaynağın kesişimi, AI’nın görsel dünyayı nasıl “görüyor” olduğunu anlamamızı sağlıyor. Ancak bu süreç tamamen şeffaf değil. Google, hangi resimlerin toplandığını, kimin izniyle olduğunu açıklamıyor. TestMu AI ise bu verilerin test edilmesiyle, bir tür “görsel etik denetimi” yapıyor. Bu, bir devrim değil, bir görsel demokrasi talebi.

Gelecekte, bir AI agent’in bir resmi “doğru” olarak sınıflandırması, sadece teknik bir başarı değil, toplumsal bir kabul meselesi olacak. Ve bu kabul, Google Images gibi gizli veri havuzlarından değil, açık, etik, çeşitlilik odaklı veri setlerinden doğacak.

Bu yüzden, bir CSS rehberi okumak, sadece bir web geliştiricinin işi değil. Bir AI’nın nasıl gözlendiğini anlamak, demokrasinin dijital bir boyutu.