Çoklu GPU’da Yapay Zeka: Neden Noktadan Noktaya İletişim ve Toplu İşlemler Sıradışı Öneme Sahip?

Çoklu GPU’da Yapay Zeka: Neden Noktadan Noktaya İletişim ve Toplu İşlemler Sıradışı Öneme Sahip?

Çoklu GPU’da Yapay Zeka: Neden Noktadan Noktaya İletişim ve Toplu İşlemler Sıradışı Öneme Sahip?

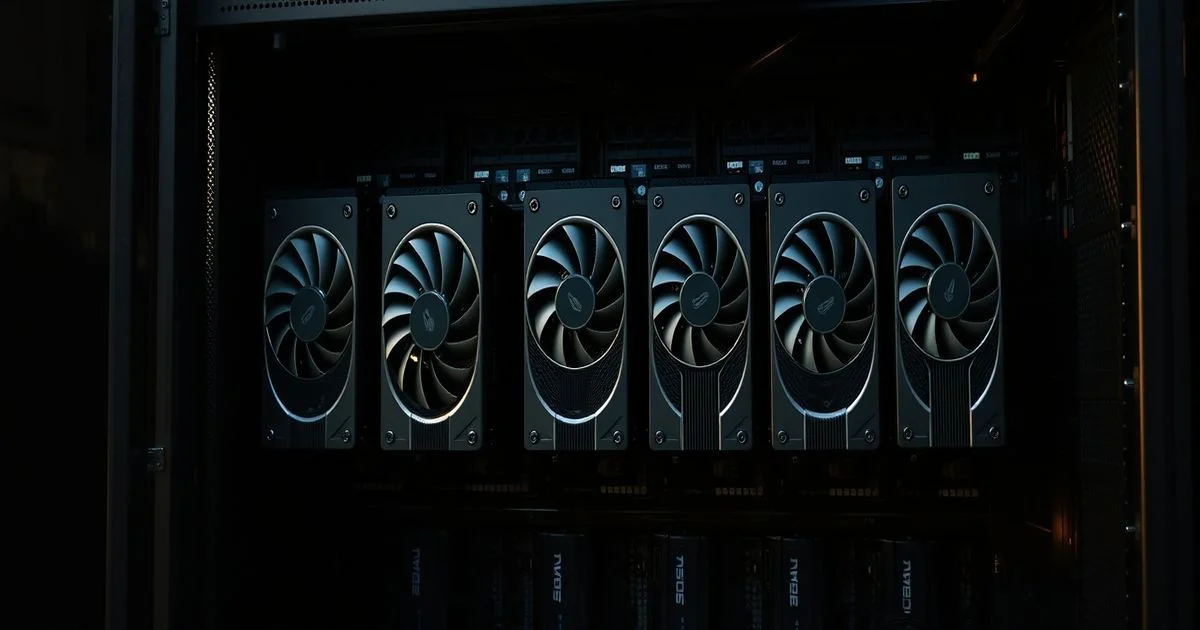

Yapay zeka dünyasında, bir modelin eğitimi artık tek bir GPU’ya değil, onlarca GPU’ya dağıtılmış bir işlem hattına dönüşmüştür. Ancak bu dağıtım, sadece donanım sayısını artırmakla değil, verilerin bu donanımlar arasında nasıl aktarıldığıyla da ilgilidir. Noktadan noktaya (point-to-point) iletişim ve toplu operasyonlar (collective operations), bu karmaşık sistemlerin kalbi gibidir — görünüp görünmeyen, ama her işlemde kritik olan yapı taşları.

Host ve Device: Bilgisayarın İki Zihnini Anlamak

Çoklu GPU sistemlerindeki ilk kritik kavram, host-device paradigmasıdır. Host, yani ana bilgisayar (genellikle CPU), verileri yönetir, komutları sıralar ve hafızayı organize eder. Device ise GPU’lardır — hesaplama gücüyle tanınan, ancak kendi kendine karar veremeyen uzmanlar. Bu iki zihin arasında veri akışı, bir orkestranın partitürünü okuyan bir şef ve orkestranın çalan müzisyenleri arasındaki ilişkiye benzer. Bir veri bloğunu GPU’ya göndermek, sadece bir dosya taşımak değil; bu veriyi GPU’nun hafızasında uygun bir şekilde yerleştirmek, erişilebilir hale getirmek ve işlem için hazırlamak demektir.

2026’da Towards Data Science’da yayınlanan bir makalede, bu paradigmanın sadece teknik bir detay değil, performansın anahtarını tuttuğu vurgulanmıştır. Eğer host, GPU’ya veriyi yeterince hızlı veya doğru şekilde gönderemezse, GPU’lar boşta kalır — tam bir kahramanın sahneye çıkmadan önce sahnenin kapalı kalması gibi. Bu yüzden, veri transferi hızı, gecikme süresi ve bellek senkronizasyonu, GPU sayısından daha önemli hale gelmiştir.

Noktadan Noktaya İletişim: Küçük Veri, Büyük Etki

Noktadan noktaya iletişim, iki cihaz arasında doğrudan veri aktarımıdır. Örneğin, bir GPU, bir diğer GPU’ya bir ağırlık vektörünü göndermek zorunda kalabilir. Bu işlem, özellikle dağıtılmış derin öğrenme modellerinde (örneğin, model paralelizminde) sıkça kullanılır. Ancak bu basit görünümlü işlem, gerçekte çok karmaşıktır. GPU’lar arasında veri taşımak, PCI Express bant genişliğini tüketir, hafıza kilitlenmelerine yol açabilir ve bazen bir GPU’nun işlem gücünü tamamen durdurabilir.

Bu tür işlemler, küçük veri paketleriyle başlar ama büyük maliyetlerle sonuçlanır. Bir modeldeki 10 milyon parametreyi, her GPU’dan diğerine sırayla göndermek, 100’den fazla bağımlı işlem gerektirir. Bu da gecikmeyi katlanarak artırır. Bu yüzden modern AI sistemlerinde, bu tür doğrudan iletişimler mümkün olduğunca azaltılır veya, daha akıllı algoritmalarla (örneğin, veri bloklaştırmaları ve önceden tahminli veri taşıma) optimize edilir.

Toplu İşlemler: Birlikte Çalışmanın Sanatı

Eğer noktadan noktaya iletişim, birbirini takip eden bireysel konuşmalar ise, toplu operasyonlar bir toplantıya benzer. Burada tüm GPU’lar aynı anda bir veriyi paylaşır, toplar, ortalama alır ya da birbirlerine sinyal verir. Örneğin, bir modelin gradyanlarını tüm GPU’lar arasında toplamak (all-reduce) en yaygın toplu operasyondur. Bu işlem, her GPU’nun kendi hesapladığı gradyanları bir araya getirip, ortalama bir gradyan oluşturarak tüm ağı aynı yöne itmesini sağlar.

Toplu işlemler, noktadan noktaya iletişimden çok daha verimlidir — çünkü tek bir komutla tüm cihazlar senkronize olur. NVIDIA’nın NCCL (NVIDIA Collective Communications Library) gibi kütüphaneler, bu işlemleri donanım düzeyinde optimize eder. Örneğin, bir 8-GPU sistemde, 8 cihaz arasında veri taşımak için 28 adet noktadan noktaya bağlantı yerine, sadece 3-4 adet toplu operasyon kullanılır. Bu, performansı %60-80 oranında artırabilir.

Neden Bu Tüm Bu Detaylar Önemli?

Bu teknik detaylar, sadece bilim insanları için değil, şirketler için de milyonlarca dolarlık fark yaratır. Bir AI modelini 10 günde eğitmek mi, yoksa 3 günde mi? Bu fark, bir ürünün piyasaya sürülme hızını, bir başlangıç şirketinin hayatta kalma şansını belirler. Özellikle büyük dil modelleri (LLM’ler) gibi, trilyonlarca parametreli sistemlerde, veri akışının en küçük gecikmesi bile günlerce ek süre demektir.

İlginç olan, bu sistemlerin çoğu, Microsoft’un bir forumda sorduğu gibi, “çoklu kriterli sorgu” gibi basit görünen sorularla başlamaz. Tam tersine, bu sistemler, milyonlarca işlem ve milyarlarca veri noktası arasında titiz bir koordinasyon gerektirir. Ve bu koordinasyon, sadece yazılım değil, donanım mimarisi, veri yolları ve hatta elektrik akışıyla ilgilidir.

Gelecek: Sıfırdan Yeni Bir Mimari

Şu anda, AI sistemleri, veri transferi gecikmelerini azaltmak için yüksek bant genişlikli bağlantılar (NVLink, InfiniBand) ve akıllı veri önbellekleme stratejileri kullanıyor. Ancak gelecekte, bu mimari tamamen değişebilir. Araştırmacılar, “veri merkezli hesaplama” (data-centric computing) ve “hafıza birleşik işlemci” (memory-processor co-design) gibi yeni yaklaşımları test ediyor. Bu modellerde, GPU’lar sadece hesaplamakla kalmaz, aynı zamanda veriyi yönetir ve hatta birbirleriyle doğrudan iletişim kurar — host’un rolü azalır.

Özetle, çoklu GPU’da yapay zeka, sadece daha çok işlemci demek değildir. Bu, verilerin nasıl akıştığını, nasıl senkronize edildiğini ve nasıl bir araya getirildiğini anlamaktır. Noktadan noktaya iletişim ve toplu operasyonlar, bu akışın iki temel kanalıdır. Birini ihmal etmek, bir orkestrayı sadece çalgılarıyla değil, aynı zamanda seslerin nasıl birleştiğini de unutmuş olmak gibidir.

Yapay zeka, artık yalnızca algoritmalarla değil, veri akışlarıyla da kazanılır. Ve bu akış, gizli mimari detaylarda saklıdır — onları anlamak, geleceğin AI liderlerini tanımlar.