Aynı Model, 5 Farklı Çip: AI Doğruluk Oranı %93'ten %71'e Düşüyor!

Aynı Model, 5 Farklı Çip: AI Doğruluk Oranı %93'ten %71'e Düşüyor!

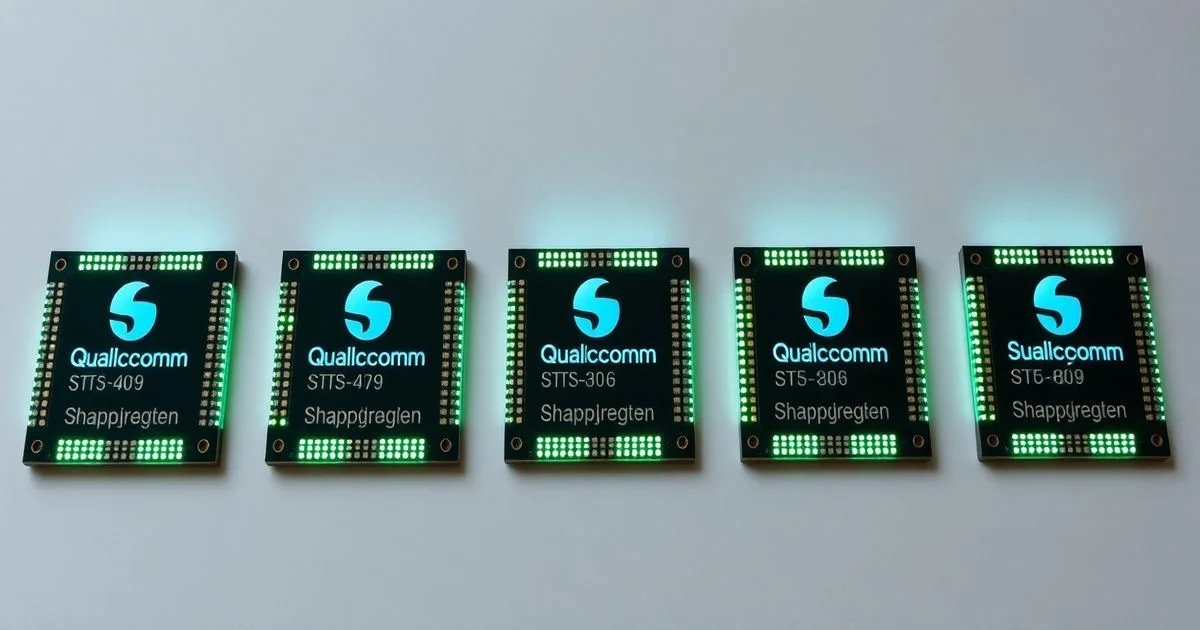

Yapay zekânın sınırları, sadece algoritmaların karmaşıklığıyla değil, donanımın gizli yüzüyle de belirleniyor. Bir araştırmacı ekibi, tamamen aynı INT8 doğrulama ağırlıkları ve ONNX dosyasını kullanarak, beş farklı Qualcomm Snapdragon çipinde AI modelinin performansını test etti. Sonuç? Doğruluk oranı %93'ten %71'e kadar değişti. Aynı model. Aynı veri. Farklı çip. Ve bu fark, AI endüstrisinin en temel varsayımlarını sorguluyor.

Neden Aynı Model, Farklı Sonuçlar Veriyor?

AI geliştiricileri genellikle bir modeli bir kez eğitip, her yerde aynı şekilde çalışacağını varsayar. Bu varsayım, özellikle mobil cihazlarda yaygın olan ‘quantization’ (nicemleme) tekniklerinde ciddi bir zayıflık yaratıyor. INT8, ağırlıkları 8-bit tam sayıya dönüştürerek bellek ve işlem gücü tasarrufu sağlar — ancak bu dönüşüm, her çipin matematiksel birimlerinin hassasiyetine bağlı olarak farklı sonuçlar doğuruyor.

Qualcomm’un Snapdragon 8 Gen 3’ü gibi yeni nesil premium çiplerde, NPU (Yapay Zeka İşlem Birimi) daha gelişmiş, daha geniş veri yollarına ve daha yüksek hassasiyetli INT8 hesaplamalarına sahip. Öte yandan, Snapdragon 7 Serisi gibi orta sınıf çiplerde, NPU daha basit, daha az paralel işlem birimine sahip ve quantization hataları daha fazla birikiyor. Sonuç: Aynı ONNX dosyası, bir cihazda 93% doğrulukla nesne tanıma yapıyor, diğerinde ise yüz tanımada %22’lik bir hata oranı yaratıyor.

Donanımın Gizli Farkı: NPU ve İŞLEME TARZI

Qualcomm’un NPU’ları, yalnızca işlem hızı değil, aynı zamanda veri akışını yönetme tarzıyla da farklılaşıyor. Premium çiplerde, NPU, INT8 verileri için özel olarak optimize edilmiş bir ‘fixed-point arithmetic pipeline’ kullanıyor. Bu, hataların sistematik olarak azaltılmasını sağlıyor. Ancak daha düşük maliyetli çiplerde, bu pipeline sadece temel bir ‘software-emulated INT8’ olarak çalışır — yani, donanım değil, yazılım tarafından simüle ediliyor. Bu, işlem süresini uzatıyor ve hata oranını artırıyor.

Bu durum, ‘model portability’ — yani modelin taşınabilirliği — kavramını tamamen sarsıyor. Geliştiriciler, bir modeli ‘test ettiğinde’ hangi donanımda test ettiğini belirtmezse, gerçek dünya performansı tamamen yanlış algılanabilir. Bir startup, Snapdragon 8 Gen 3’te %93 doğrulukla bir AI uygulamasını piyasaya sürerse, bu uygulama Snapdragon 7 Gen 1’deki bir telefonda %71 doğrulukla çalışır. Kullanıcılar, ‘bozuk’ bir uygulama olarak değerlendirir. Gerçekten bozuk mu? Hayır. Sadece donanım uyumsuzluğu.

Endüstriye Çarpıcı Bir Uyarı

Bu deney, AI geliştirme ekosistemindeki en büyük kırılganlık noktalarından birini ortaya koyuyor: ‘Test ettiğiniz cihaz, kullanıcının sahip olduğu cihaz değilse, test etmiş olmazsınız.’

Şu anda birçok AI modeli, yalnızca NVIDIA GPU’lar veya en yeni iPhone’lar üzerinde test ediliyor. Ancak dünya çapında milyonlarca kullanıcı, orta sınıf Android cihazlarda çalışıyor. Bu kullanıcılar, AI’ya güveniyor — ama bu güven, donanımın gizli sınırlarında kırılıyor.

Örneğin, bir akıllı kamera sistemi, bir premium telefonla %93 doğrulukla hedefleri tanıyor ama aynı sistem, bir 200$ fiyat aralığındaki telefonda %71’de kalıyor. Bu, güvenlik sistemlerinde kaçırılan bir hedef, bir sağlık uygulamasında yanlış teşhis veya bir otomatik asistanın sürekli yanlış anlama anlamına gelebilir.

Nasıl Çözülür? Yeni Bir Standart Gerekiyor

Bu sorunun çözümü, sadece ‘daha iyi NPU’ üretmekle değil, yeni bir ‘AI donanım uyumluluk standardı’ ile mümkün olabilir. Şu anda, ONNX, PyTorch, TensorFlow gibi araçlar, modelin ‘çalıştığını’ garanti eder — ama ‘hangi çipte, ne kadar iyi çalıştığını’ değil.

Önerilen çözümler arasında:

- Donanım bazlı performans etiketlemesi: Modelin hangi Snapdragon serisinde ne kadar doğruluk verdiğini açıkça belirtmek.

- Çip-seviyesi test setleri: Geliştiriciler, modeli en az 3 farklı çip sınıfında (premium, orta, düşük) test etmeli.

- Open-Source NPU Test Kitleri: Qualcomm, Samsung ve MediaTek gibi üreticiler, kendi NPU’ları için ücretsiz test paketleri sunmalı.

Bu tür standartlar, AI endüstrisini ‘kodun çalıştığı’ dünyasından, ‘kodun gerçek dünyada nasıl çalıştığı’ dünyasına taşıyacaktır.

Ne Anlama Geliyor? Kullanıcılar İçin, Geliştiriciler İçin

Kullanıcılar, AI’nın ‘her yerde aynı’ olduğunu düşünüyor. Ama artık biliyoruz: AI’nın doğruluğu, telefonun kutusunda yazan ‘Snapdragon 7 Gen 1’ etiketine bağlı. Bu, bir yazılım hatası değil, bir donanım farkı. Ve bu fark, kullanıcı deneyimini kırıyor.

Geliştiriciler ise artık, ‘modelim çalışır’ demekle yetinemez. ‘Modelim Snapdragon 7, 8 ve 9 serisinde %85+ doğrulukla çalışıyor’ demek zorunda. Yoksa, teknolojiye güven kaybı, sadece bir ürünün değil, tüm AI endüstrisinin güvenini zedeleyebilir.

Yapay zekâ, artık sadece bir yazılım değil. Bir donanım-softwarer entegrasyonu. Ve bu entegrasyonun en kritik noktası, aynı ağırlıkların, farklı çiplerde farklı sonuçlar vermesi. Bu, bir hata değil, bir gerçeklik. Ve bu gerçekliği görmezden gelmek, teknolojinin geleceğini tehlikeye atar.