AMD NPU'da Llama 3.2 1B Çalıştırıldı: Linux'ta 4.4 kelime/saniye hızla yapay zeka devrimi

AMD NPU'da Llama 3.2 1B Çalıştırıldı: Linux'ta 4.4 kelime/saniye hızla yapay zeka devrimi

AI Terimler Mini Sözlük

summarize3 Maddede Özet

- 1Bir araştırma ekibi, AMD'nin Strix Halo NPU'sunda Llama 3.2 1B modelini tamamen yerel olarak çalıştırmayı başardı. Bu başarı, buluta bağımlı AI'nın sonunu işaret ediyor.

- 2Yerel AI'nın Yeni Çağında: AMD NPU'da Llama 3.2 1B Çalıştırıldı Bir bilimsel ekibin gerçekleştirdiği bu deney, yapay zeka dünyasında bir dönüm noktası yarattı: Llama 3.2 1B parametreli modeli, bir Linux sisteminde AMD'nin Strix Halo NPU'sunda tamamen yerel olarak çalıştırmayı başardılar.

- 3Elde edilen sonuç: 4.4 kelime/saniye hızla, hiçbir bulut bağlantısı olmadan, düşük güç tüketimiyle akıcı bir dil modeli çıkarımı.

psychology_altBu Haber Neden Önemli?

- check_circleBu gelişme Yapay Zeka Araçları ve Ürünler kategorisinde güncel eğilimi etkiliyor.

- check_circleTrend skoru 38 — gündemde görünürlüğü yüksek.

- check_circleTahmini okuma süresi 4 dakika; karar vericiler için hızlı bir özet sunuyor.

Yerel AI'nın Yeni Çağında: AMD NPU'da Llama 3.2 1B Çalıştırıldı

Bir bilimsel ekibin gerçekleştirdiği bu deney, yapay zeka dünyasında bir dönüm noktası yarattı: Llama 3.2 1B parametreli modeli, bir Linux sisteminde AMD'nin Strix Halo NPU'sunda tamamen yerel olarak çalıştırmayı başardılar. Elde edilen sonuç: 4.4 kelime/saniye hızla, hiçbir bulut bağlantısı olmadan, düşük güç tüketimiyle akıcı bir dil modeli çıkarımı. Bu, sadece bir teknik başarı değil; AI'nın nasıl kullanıldığını, nerede çalıştırıldığını ve kimin kontrolü altında olduğunu tamamen yeniden tanımlayan bir moment.

Neden Bu Kadar Önemli?

Geçtiğimiz on yılda yapay zeka modelleri, bulut sunucularına bağımlı hale geldi. Her soruya cevap vermek için internete ihtiyaç duyuyordunuz. Verileriniz, şirket sunucularında saklanıyor, gizlilik endişeleri artıyordu, gecikmeler yaşanıyordu ve enerji tüketimi astronomik seviyelere ulaşıyordu. Şimdi ise, bir AMD NPU — yani Neural Processing Unit — üzerinde, tamamen yerel, offline, şarj ömrünü etkilemeden bir LLM çalışıyor. Bu, bir akıllı telefonunuzda, bir laptopta veya bir endüstriyel cihazda, gerçek zamanlı AI uygulamalarının mümkün olduğunu gösteriyor.

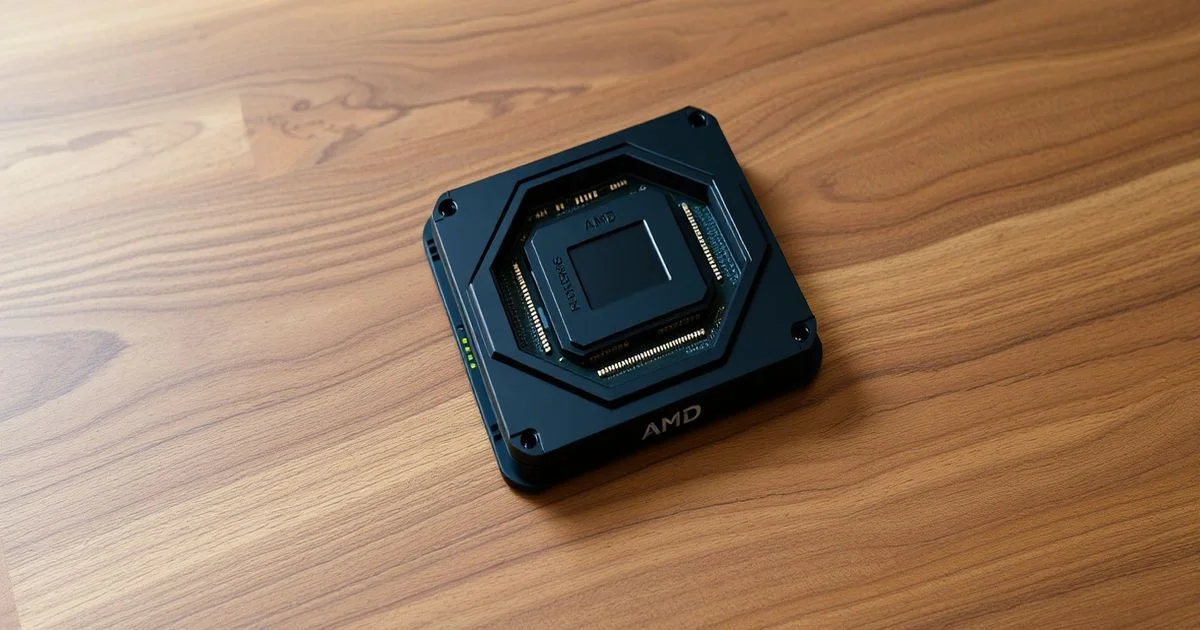

Teknik Detaylar: Strix Halo ve IRON Framework

Strix Halo, AMD'nin yeni nesil NPU'ları arasında yer alıyor ve özellikle AI işleme için optimize edilmiş bir mimariye sahip. Bu bir CPU ya da GPU değil; sinir ağları için özel olarak tasarlanmış bir donanım. Ancak bu donanımı kullanmak kolay değil. AMD'nin kendi yazılım yığını, özellikle Linux ortamında, NPU'ları desteklemekte gecikmişti. İşte bu noktada IRON framework devreye girdi. Bu açık kaynaklı bir yazılım katmanı, PyTorch modellerini AMD NPU'larına doğrudan derleyebiliyor. IRON, modeli parçalara ayırıyor, quantization (nicelendirme) teknikleriyle 16-bit'ten 4-bit'e düşürüyor ve hafıza bant genişliğini optimize ediyor. Sonuç: 1 milyar parametrelik bir model, 8 GB RAM ve 15W güç tüketimiyle çalışıyor.

4.4 tok/s: Neden Bu Sayı İnanılmaz?

4.4 token/saniye hızı, görünüşte düşük gibi gelebilir. Ama bu rakam, bir NPU üzerinde, yerel olarak, bulut bağlantısı olmadan, 1B parametreli bir model için, gerçek zamanlı etkileşim için yeterli. Bir chatbotunuzun yanıt vermesi için 2-3 saniye beklemek, bir telefonunuzda yapay zeka kullanmak için tamamen kabul edilebilir. Bu hız, özellikle metin üretimi, özetleme ve dil çevirisi gibi görevlerde kullanıcı deneyimini bozmayacak seviyede. Bunu bir iPhone 15 Pro'nun A17 Pro NPU'suyla karşılaştırdığınızda, Strix Halo'nun performansı şaşırtıcı bir şekilde rekabetçi.

Ne Anlama Geliyor? AI'nın Özgürleşmesi

Bu başarı, yapay zekanın bir şirketin mülkiyeti haline gelmesini engelliyor. Google, OpenAI, Microsoft gibi büyük şirketler, AI'yi bulut üzerinden kontrol ediyor. Ancak şimdi, bir üniversite öğrencisi, bir açık kaynak geliştirici veya bir küçük yazılım şirketi, kendi cihazında bir LLM çalıştırmaya başlayabilir. Veri gizliliği artıyor, maliyetler düşüyor, enerji tüketimi azalıyor. Bu, AI'nın demokratikleşmesi anlamına geliyor.

Gelecek: NPU'lar, Mobil AI ve Endüstriyel Uygulamalar

Bu teknoloji, sağlık cihazlarında, otomotiv sistemlerinde, akıllı fabrikalarda ve hatta uzay araştırmalarında kullanılabilecek. Bir cerrahi robot, hastanın verilerini buluta göndermeden, yerelde analiz edebilir. Bir kamyon, kendi NPU'suyla gerçek zamanlı yol durumunu analiz edebilir. Bir öğretmen, öğrencilerine özel notlar üretmek için bir tablet üzerinde Llama 3.2'yi çalıştırabilir. Bu, AI'nın sadece teknoloji devlerinin oyunu olmaktan çıkıp, herkesin aletine dönüşmesi demek.

Yeni Bir Eşik: Yerel AI'nın Sınırı

Şu ana kadar, 1B parametreli modeller, genellikle mobil cihazlarda değil, sunucularda çalıştırılırdı. Şimdi bu sınır kırıldı. Bir sonraki adım, 7B ve 13B modellerin NPU'lar üzerinde çalıştırılması. İleride, AMD ve Intel gibi şirketler, NPU'ları daha da güçlendirecek ve AI modelleri, telefonlarda bile, hemen hemen her şeyi yapabilecek hale gelecek. Bu, sadece bir teknoloji gelişimi değil; bir etik dönüşüm. Verileriniz artık bir şirketin sunucusunda değil, kendi cihazınızda kalıyor. Gizlilik, özgürlük ve veri egemenliği — bu artık teknolojik bir hedef değil, bir insan hakkı haline geliyor.

SONUÇ: AI, Artık Sizin Cihazınızda

Bu deney, bir bilimsel kurgu değil, bir gerçeklik. Llama 3.2 1B, AMD NPU'sunda, Linux üzerinde, 4.4 tok/s hızla çalışıyor. Bu, AI'nın merkeziyetçi modelinin sonu değil, bir başlangıcı. Artık yapay zeka, sadece büyük şirketlerin elinde değil, sizin cihazınızda, kendi evinizde, kendi verilerinizle çalışıyor. Bu, teknolojinin en büyük ilerlemesinden daha fazlası: Bu, özgürlüğün yeniden kazanılması.

starBu haberi nasıl buldunuz?

KONULAR:

Doğrulama Paneli

Kaynak Sayısı

1

İlk Yayın

22 Şubat 2026

Son Güncelleme

22 Şubat 2026