AI ve Çoklu GPU'lar: Bilgisayarın Zihnini Nasıl Çoğaltıyoruz?

AI ve Çoklu GPU'lar: Bilgisayarın Zihnini Nasıl Çoğaltıyoruz?

AI ve Çoklu GPU'lar: Bilgisayarın Zihnini Nasıl Çoğaltıyoruz?

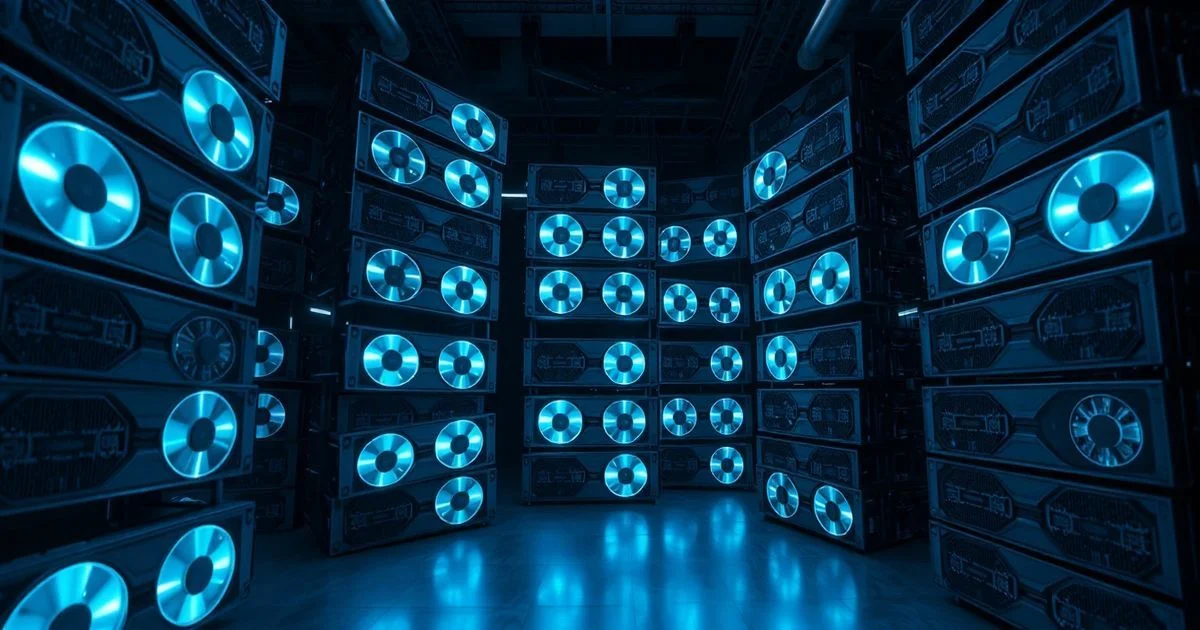

Bir yapay zeka modeli, bir insan beyni gibi değil—daha çok bir orkestranın sahne alması gibi. Tek bir müzik aletiyle symfoni çalabilmek mümkün değil; her enstrüman, her ses, her ritim, farklı bir kaynaktan geliyor. İşte AI’da da aynı şey geçerli: Tek bir GPU, modern derin öğrenme modellerinin hesaplama yükünü taşıyamıyor. Bu yüzden mühendisler, bilgisayarın zihnini çoğaltmaya çalışıyorlar—birden fazla GPU’yu, bir araya getirip, birlikte düşünmeye zorluyorlar. Ama bu sadece donanım eklemek demek değil. Bu, bir paradigma değişimi.

Host ve Device: Bilgisayarın İki Zihnini Anlamak

Çoklu GPU’lu sistemlerdeki temel yapı, host-device paradigması olarak bilinir. Host, genellikle bilgisayarın CPU’sudur—yani ana akıl. Device ise GPU’lardır—çok sayıda küçük zihin, aynı anda binlerce işlemi yapabilen, ancak kendi başlarına karar alamayan, yalnızca komut bekleyen asistanlar. Bu ikili, bir şef ve orkestranın müzisyenleri gibidir. Şef (host) partitürü okur, her enstrümana (GPU) ne zaman, ne çalacağını söyler. Müzisyenler (device) ise sadece komutu yerine getirir, ancak bu komutlar milyonlarca kez tekrarlandığında, sonucu bir senfoni haline getirir.

Peki neden bu kadar karmaşık? Çünkü GPU’lar, CPU’lardan tamamen farklı mimariye sahiptir. CPU’lar birkaç güçlü çekirdek ile karmaşık kararlar alır, bellek erişimini optimize eder. GPU’lar ise binlerce zayıf çekirdek ile aynı işlemi binlerce kez paralel olarak yapar. AI’da bu, bir resimdeki milyonlarca pikselin aynı anda işlenmesi anlamına gelir. Ama bu paralellik, sadece veriyi GPU’lara göndermekle başlamaz. Veri, önce host’tan belleğe (RAM’den GPU’ya) kopyalanır. İşlem bittikten sonra, sonuç tekrar host’a döner. Bu veri taşımaları, işlem zamanının %30-50’sini bile kaplayabilir. Bu yüzden modern AI sistemlerinde, veri akışını optimize etmek, hesaplama gücünden daha kritik hale gelmiştir.

Paradigma Değişimi: Sadece Donanım Artışı Değil

2010’larda AI, tek bir GPU ile sınırlıydı. 2020’lerde ise bir AI modeli, 8, 16 hatta 128 GPU’yu bir araya getirerek eğitiliyor. Ama bu sadece sayı artışı değil. Bu, yazılım mimarisinin tamamen yeniden inşası anlamına geliyor. NVIDIA’nın CUDA platformu, bu paradigmayı mümkün kılan ilk büyük adım oldu. Ama şimdi, bu yapıyı aşmak için yeni teknolojiler geliyor: NCCL (NVIDIA Collective Communications Library), PyTorch DDP, TensorFlow MirroredStrategy gibi araçlar, birden fazla GPU arasında veri senkronizasyonunu, gradyan paylaşımını ve hata toleransını otomatikleştiriyor.

Bu sistemler, aslında bir “dağıtık zeka” oluşturuyor. Her GPU, modelin bir parçasını saklıyor, bir kısmını hesaplıyor, ve sonuçları diğerlerine gönderiyor. Bu, bir insanın beyninin sol ve sağ yarımküresinin birbirini tamamlaması gibi. Ama burada fark, bu yarımküreler fiziksel olarak farklı cihazlarda olabiliyor—bir veri merkezindeki farklı sunucularda bile. Bu, AI’nın artık bir bilgisayarda değil, bir ağda yaşaması anlamına geliyor.

Neden Bu Kadar Önemli? Bir Dijital Devrimin Kapısı

Bu yapı, sadece teknik bir detay değil. Bu, yapay zekanın nasıl gelişeceğini, kimin kontrol edeceğini ve ne kadar hızlı olacağını belirliyor. Tek bir şirketin, 1000 GPU’luk bir cluster’a sahip olması, bir ülkenin AI liderliği için yeterli olabilir. Ama aynı zamanda, bu sistemlerin karmaşıklığı, küçük şirketlerin ve akademik laboratuvarların erişimini zorlaştırıyor. Bu, teknolojik eşitsizliğin yeni bir yüzü.

Öte yandan, bu paradigma, enerji verimliliğini de yeniden tanımlıyor. 2025’e kadar AI modellerinin %60’ı çoklu GPU sistemlerinde eğitilecek. Bu, hem maliyet hem de karbon ayak izi açısından büyük bir sorun. Ancak bu sistemler, aynı zamanda daha az enerjiyle daha fazla iş yapma potansiyeline sahip. Çünkü paralel işlem, tek bir güçlü işlemciye göre daha az kaynak tüketebilir—eğer veri akışı doğru yönetilirse.

Gelecek: Host ve Device Arasında Bir Sinerji

Gelecekte, host ve device arasındaki sınır bulanıklaşacak. Nöromorfik çipler, AI accelerators ve HBM (High Bandwidth Memory) gibi teknolojiler, veri taşıma gecikmesini azaltıyor. Qualcomm’un yeni AI chip’leri, CPU, GPU ve NPU’yu tek bir çip üzerinde birleştiriyor. Bu, host-device ayrımını yavaş yavaş ortadan kaldırıyor. Ama bu, paradigmanın sonu değil—onun evrimi.

Yapay zeka, artık bir alet değil, bir organizma. Ve bu organizmanın zihnini çoğaltmak, sadece daha fazla GPU almakla değil, onları nasıl bir araya getirdiğinizle, nasıl iletişim kurduğunuzla, nasıl birlikte düşünmeye zorladığınızla ilgili. Host, zihni yönlendirir. Device, zihni çoğaltır. Birlikte, insan zihninin ötesine geçiyorlar.

Yeni nesil AI sistemleri, artık sadece hesap makinesi değil—birlikte düşünme sanatı.