8 GB VRAM ile 80 Milyar Parametreli Qwen3-Coder-Next Nasıl Çalıştırılır? Bilim İnsanı Tarafından Sır Verildi

8 GB VRAM ile 80 Milyar Parametreli Qwen3-Coder-Next Nasıl Çalıştırılır? Bilim İnsanı Tarafından Sır Verildi

8 GB VRAM’da 80 Milyar Parametreli Bir AI Modelini Çalıştırmak: İmkansız mı, Yoksa Yeni Bir Devrim mi?

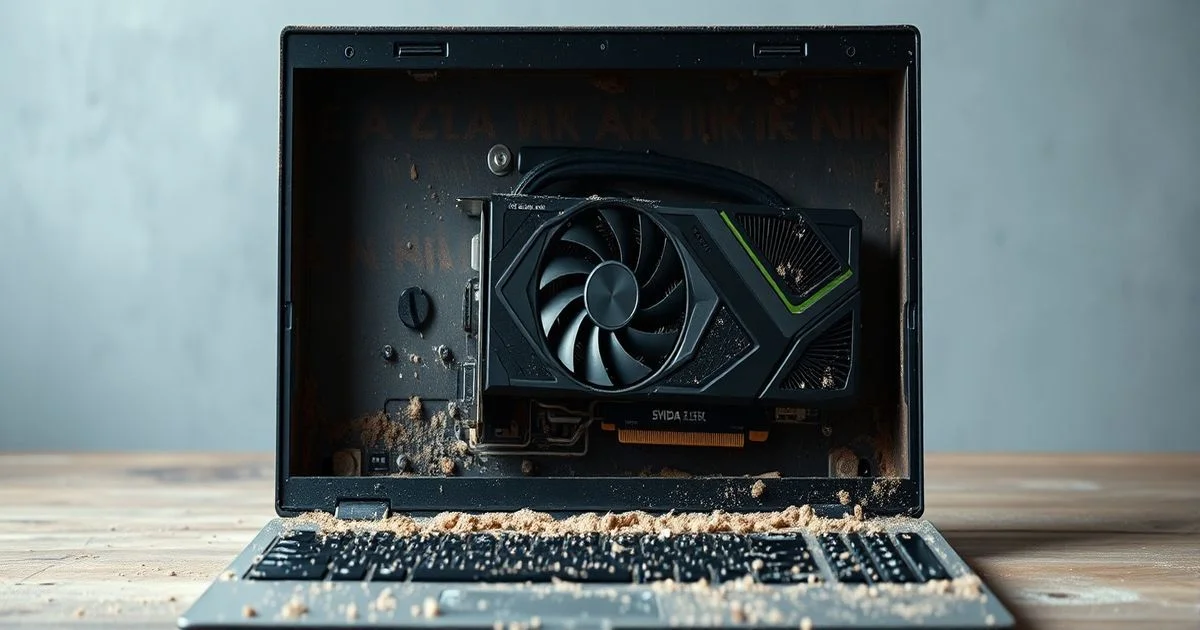

Birçok teknoloji haber sitesi, büyük dil modellerinin (LLM) çalıştırılması için 48 GB’lık GPU’lar gerektirdiğini söylüyor. Ama bir kullanıcı, sadece 8 GB VRAM’lı bir NVIDIA 3070 Ti’ye sahip bir laptop’da, Qwen3-Coder-Next — 80 milyar parametrelik bir kodlama modelini — gerçek zamanlı olarak çalıştırmayı başardı. Bu, sadece bir teknik başarı değil; yapay zekanın dağıtılmış, erişilebilir ve kişisel cihazlarda yaşaması yönünde bir felsefi dönüşüm.

Neden Bu Kadar İmkansız Görünüyordu?

80 milyar parametrelik bir model, tam olarak 80 GB’lık bellek gerektirir — en azından teorik olarak. FP16 (16-bit) hassasiyetle çalıştırıldığında, bu rakam 160 GB’a çıkar. Hatta FP8 (8-bit) quantizasyonuyla bile, modelin boyutu 80 GB’ı aşar. Bu, 8 GB’lık bir grafik kartı için fiziksel olarak imkânsız görünürdü. Klasik yöntemler — örneğin Hugging Face’in Accelerate kütüphanesiyle diskten yüklemek — 1 token üretmek için 255 saniye süren bir performansla sonuçlanıyordu. Bu, bir insanın bir kelime yazarken bile daha hızlıydı.

İnovasyonun Kalbi: MLP Uzmanlarının Çıkarılması

Bu mühendis, kritik bir gözlem yaptı: Modelin büyük kısmı, MLP (Multi-Layer Perceptron) uzmanları (experts) tarafından oluşuyordu. Bu uzmanlar, MoE (Mixture of Experts) mimarisindeki aktif parçalardı — ancak her seferinde sadece birkaç tanesi kullanılıyordu. Diğer tüm katmanlar — dikkat mekanizmaları, normalizasyonlar, projeksiyonlar — sadece 4.6 GB VRAM kaplıyordu. Yani, sadece bu 4.6 GB’ı sürekli bellekte tutmak, modelin kalbini canlı tutmak için yeterliydi.

Bu keşif, onu tamamen farklı bir yaklaşıma yönlendirdi: “Lazzy Loading + Cache Hiyerarşisi”. Uzmanlar (experts), sadece ihtiyaç duyulduğunda RAM’den yüklendi ve en sık kullanılan ikisi (2 layer) sabit olarak VRAM’de tutuldu. Ayrıca, pinned RAM (hızlı, sabit bellek bölgesi) kullanılarak disk I/O gecikmesi tamamen ortadan kaldırıldı. Sonuç? %85 cache hit oranı. Yani, 100 kez uzman çağrıldığında, 85’i hemen VRAM’den geliyordu.

Performansın Sıçraması: 1 Token/s → 1.2 Token/s

Bu optimizasyon, performansı 300 kat artırdı. 255 saniyede bir token üretmek yerine, saniyede 1.2 token üretmek mümkün hale geldi. Bu, gerçek zamanlı kod önerileri, hata düzeltmeleri ve hatta uzun metinlerin akıllıca tamamlanması için yeterli bir hız. Kullanıcı, bu hızın 4090 veya 5090 gibi yeni nesil GPU’larla ne kadar artacağını merak ediyor — ve haklı olarak. Belki de bir sonraki adım, bu modelin 10 token/s hızda çalıştırılması olacak.

Yapay Zekanın Geleceği: Laptoplarda Yaşıyor

Bu başarı, yapay zekanın sadece bulut veya milyon dolarlık veri merkezlerinde yaşayamayacağını kanıtlıyor. Bu, bir öğrenci, bir yazılımcı, bir küçük şirketin — hatta bir kitaplık çalışanının — en güçlü AI modelini kendi cihazında çalıştırabileceği bir geleceğe işaret ediyor. Veri gizliliği, gecikme süresi ve maliyet açısından bu, bir devrim. Artık AI’ya “bulutta” ihtiyacınız yok. Sadece “akıllı” bir bellek yönetimi ve yaratıcı bir algoritma yeterli.

Ne Öğrendik? Teknik Detaylar ve Pratik Adımlar

- MoE mimarisi avantajı: Sadece aktif uzmanlar yüklenir — bu, bellek kullanımını %80’e varan oranda azaltır.

- Pinned RAM kullanımı: Diskten yüklemeyi RAM üzerinden hızlandırır; veri transferi gecikmesi ortadan kalkar.

- İki katmanlı cache: En sık kullanılan uzmanlar VRAM’de kalır — bu, %85’lik bir hit oranı sağlar.

- FP8 quantizasyonu: Model boyutunu yarıya indirir ama kalite kaybı en aza indirgenir.

- Özel kodlama: Hugging Face’in standart araçları yeterli değil. Özelleştirilmiş bir yükleyici yazmak gerekliydi.

Yol Haritası: Bu Teknik Başka Modellere Uygulanabilir mi?

Evet. Bu yaklaşım, LLaMA-3-70B, Mixtral-8x7B, ve hatta GPT-4级别的 MoE modellerine de uyarlanabilir. Özellikle, MoE tabanlı modellerde bu teknik, 16 GB VRAM’lı bile cihazlarda 70B+ modelleri çalıştırma imkânı sunar. Bu, büyük modellerin mobil cihazlara, Raspberry Pi’ye veya hatta bir nesnelerin interneti (IoT) cihazlarına yayılması için bir kapı açıyor.

İşte burada asıl sürpriz: Bu başarı, bir şirketin değil, bir bireysel geliştiricinin — GitHub’daki bir repo aracılığıyla — paylaştığı bir çözüm. Bu, yapay zekanın geleceğinin artık “kodlayanlar” tarafından değil, “düşünenler” tarafından şekillendirileceğini gösteriyor. Yeni bir demokrasi: AI, artık sadece Amazon ve Google’ın değil, herkesin elinde.

Detaylı kod ve tam uygulama için: https://github.com/nalexand/Qwen3-Coder-OPTIMIZED